দ্রষ্টব্য: এই পৃষ্ঠাটি Camera2 প্যাকেজকে বোঝায়। আপনার অ্যাপের Camera2 থেকে নির্দিষ্ট, নিম্ন-স্তরের বৈশিষ্ট্যের প্রয়োজন না হলে, আমরা CameraX ব্যবহার করার পরামর্শ দিই। CameraX এবং Camera2 উভয়ই Android 5.0 (API স্তর 21) এবং উচ্চতর সমর্থন করে।

মাল্টি-ক্যামেরা Android 9 (API স্তর 28) এর সাথে চালু করা হয়েছিল। এটি প্রকাশের পর থেকে, ডিভাইসগুলি বাজারে এসেছে যা API সমর্থন করে। অনেক মাল্টি-ক্যামেরা ব্যবহারের ক্ষেত্রে একটি নির্দিষ্ট হার্ডওয়্যার কনফিগারেশনের সাথে শক্তভাবে মিলিত হয়। অন্য কথায়, সমস্ত ব্যবহারের ক্ষেত্রে প্রতিটি ডিভাইসের সাথে সামঞ্জস্যপূর্ণ নয়, যা মাল্টি-ক্যামেরা বৈশিষ্ট্যগুলিকে প্লে বৈশিষ্ট্য ডেলিভারির জন্য একটি ভাল প্রার্থী করে তোলে৷

কিছু সাধারণ ব্যবহারের ক্ষেত্রে অন্তর্ভুক্ত:

- জুম : ক্রপ অঞ্চল বা পছন্দসই ফোকাল দৈর্ঘ্যের উপর নির্ভর করে ক্যামেরার মধ্যে স্যুইচ করা।

- গভীরতা : একটি গভীরতার মানচিত্র তৈরি করতে একাধিক ক্যামেরা ব্যবহার করে।

- বোকেহ : ডিএসএলআর-এর মতো সংকীর্ণ ফোকাস পরিসর অনুকরণ করতে অনুমানকৃত গভীরতার তথ্য ব্যবহার করে।

লজিক্যাল এবং ফিজিক্যাল ক্যামেরার মধ্যে পার্থক্য

মাল্টি-ক্যামেরা API বোঝার জন্য লজিক্যাল এবং ফিজিক্যাল ক্যামেরার মধ্যে পার্থক্য বোঝা প্রয়োজন। রেফারেন্সের জন্য, তিনটি ব্যাক-ফেসিং ক্যামেরা সহ একটি ডিভাইস বিবেচনা করুন। এই উদাহরণে, তিনটি পিছনের ক্যামেরার প্রতিটিকে একটি ফিজিক্যাল ক্যামেরা হিসেবে বিবেচনা করা হয়। একটি লজিক্যাল ক্যামেরা তখন সেই দুটি বা তার বেশি ফিজিক্যাল ক্যামেরার একটি গ্রুপিং। লজিক্যাল ক্যামেরার আউটপুট একটি স্ট্রীম হতে পারে যা একটি অন্তর্নিহিত ফিজিক্যাল ক্যামেরা থেকে আসে, অথবা একটি ফিউজড স্ট্রীম একই সাথে একাধিক অন্তর্নিহিত ফিজিক্যাল ক্যামেরা থেকে আসে। যেভাবেই হোক, স্ট্রিমটি ক্যামেরা হার্ডওয়্যার অ্যাবস্ট্রাকশন লেয়ার (HAL) দ্বারা পরিচালিত হয়।

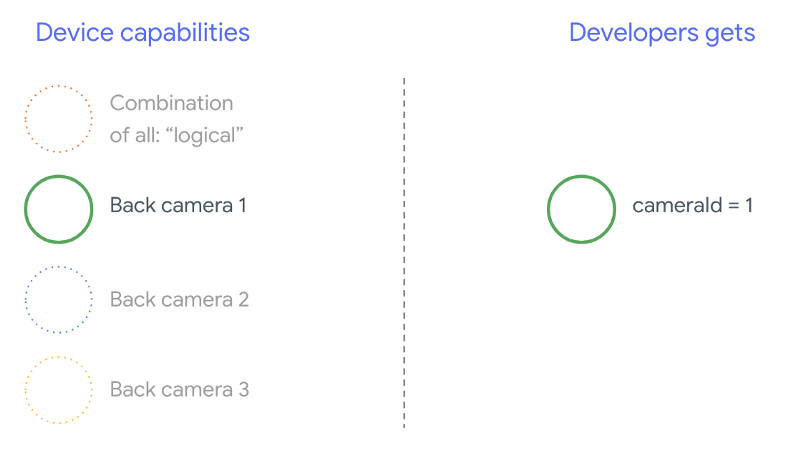

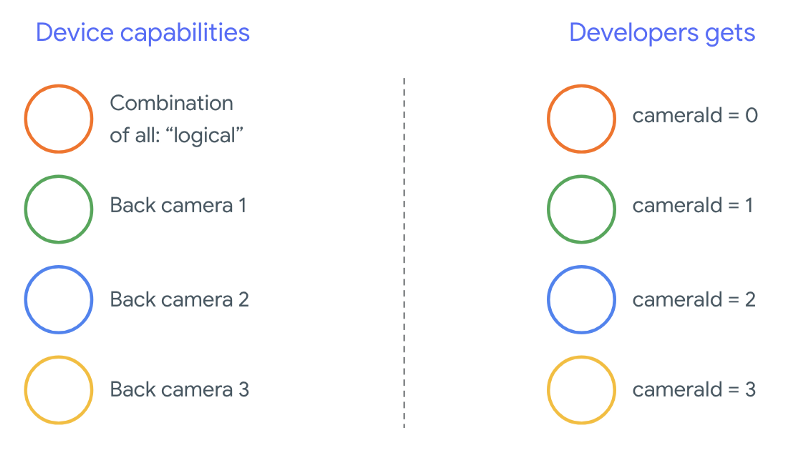

অনেক ফোন নির্মাতারা ফার্স্ট-পার্টি ক্যামেরা অ্যাপ্লিকেশান তৈরি করে, যেগুলো সাধারণত তাদের ডিভাইসে আগে থেকে ইনস্টল করা থাকে। হার্ডওয়্যারের সমস্ত ক্ষমতা ব্যবহার করার জন্য, তারা ব্যক্তিগত বা লুকানো API ব্যবহার করতে পারে বা ড্রাইভার বাস্তবায়ন থেকে বিশেষ চিকিত্সা গ্রহণ করতে পারে যা অন্যান্য অ্যাপ্লিকেশনগুলির অ্যাক্সেস নেই৷ কিছু ডিভাইস বিভিন্ন ফিজিক্যাল ক্যামেরা থেকে ফ্রেমের একটি ফিউজড স্ট্রিম প্রদান করে লজিক্যাল ক্যামেরার ধারণা বাস্তবায়ন করে, কিন্তু শুধুমাত্র কিছু বিশেষ সুবিধাপ্রাপ্ত অ্যাপ্লিকেশনের জন্য। প্রায়শই, শুধুমাত্র একটি শারীরিক ক্যামেরা ফ্রেমওয়ার্কের সাথে উন্মুক্ত হয়। অ্যান্ড্রয়েড 9-এর পূর্বে তৃতীয় পক্ষের বিকাশকারীদের পরিস্থিতি নিম্নলিখিত চিত্রটিতে চিত্রিত করা হয়েছে:

অ্যান্ড্রয়েড 9 থেকে শুরু করে, অ্যান্ড্রয়েড অ্যাপগুলিতে ব্যক্তিগত APIগুলি আর অনুমোদিত নয়৷ ফ্রেমওয়ার্কের মধ্যে মাল্টি-ক্যামেরা সমর্থন অন্তর্ভুক্ত করার সাথে, অ্যান্ড্রয়েডের সর্বোত্তম অনুশীলনগুলি দৃঢ়ভাবে সুপারিশ করে যে ফোন নির্মাতারা একই দিকের মুখোমুখি সমস্ত শারীরিক ক্যামেরার জন্য একটি লজিক্যাল ক্যামেরা প্রকাশ করে। অ্যান্ড্রয়েড 9 এবং উচ্চতর ডিভাইসে চলমান ডিভাইসগুলিতে তৃতীয় পক্ষের বিকাশকারীদের কী আশা করা উচিত তা নিম্নরূপ:

যৌক্তিক ক্যামেরা যা প্রদান করে তা সম্পূর্ণরূপে ক্যামেরা HAL এর OEM বাস্তবায়নের উপর নির্ভর করে। উদাহরণস্বরূপ, Pixel 3 এর মতো একটি ডিভাইস তার লজিক্যাল ক্যামেরাকে এমনভাবে প্রয়োগ করে যাতে অনুরোধ করা ফোকাল দৈর্ঘ্য এবং ক্রপ অঞ্চলের উপর ভিত্তি করে এটি তার একটি ফিজিক্যাল ক্যামেরা বেছে নেয়।

মাল্টি-ক্যামেরা API

নতুন API নিম্নলিখিত নতুন ধ্রুবক, শ্রেণী এবং পদ্ধতি যোগ করে:

-

CameraMetadata.REQUEST_AVAILABLE_CAPABILITIES_LOGICAL_MULTI_CAMERA -

CameraCharacteristics.getPhysicalCameraIds() -

CameraCharacteristics.getAvailablePhysicalCameraRequestKeys() -

CameraDevice.createCaptureSession(SessionConfiguration config) -

CameraCharacteritics.LOGICAL_MULTI_CAMERA_SENSOR_SYNC_TYPE -

OutputConfigurationএবংSessionConfiguration

অ্যান্ড্রয়েড কম্প্যাটিবিলিটি ডেফিনিশন ডকুমেন্টে (CDD) পরিবর্তনের কারণে, মাল্টি-ক্যামেরা এপিআই ডেভেলপারদের কাছ থেকে কিছু প্রত্যাশা নিয়ে আসে। দ্বৈত ক্যামেরা সহ ডিভাইসগুলি Android 9 এর আগে বিদ্যমান ছিল, কিন্তু একই সাথে একাধিক ক্যামেরা খোলার ক্ষেত্রে ট্রায়াল এবং ত্রুটি জড়িত ছিল। Android 9 এবং উচ্চতর, মাল্টি-ক্যামেরা একই লজিক্যাল ক্যামেরার অংশ এমন এক জোড়া ফিজিক্যাল ক্যামেরা কখন খোলা সম্ভব তা নির্দিষ্ট করার জন্য নিয়মের একটি সেট দেয়।

বেশিরভাগ ক্ষেত্রে, Android 9 এবং উচ্চতর ডিভাইসগুলি ব্যবহার করা সহজ লজিক্যাল ক্যামেরা সহ সমস্ত ফিজিক্যাল ক্যামেরা (সম্ভবত ইনফ্রারেডের মতো কম-সাধারণ সেন্সর ধরনের ব্যতীত) প্রকাশ করে। স্ট্রীমগুলির প্রতিটি সংমিশ্রণের জন্য যা কাজ করার গ্যারান্টিযুক্ত, একটি লজিক্যাল ক্যামেরার অন্তর্গত একটি স্ট্রীম অন্তর্নিহিত শারীরিক ক্যামেরা থেকে দুটি স্ট্রিম দ্বারা প্রতিস্থাপিত হতে পারে।

একাধিক স্ট্রীম একসাথে

একসাথে একাধিক ক্যামেরা স্ট্রীম ব্যবহার করা একক ক্যামেরায় একসাথে একাধিক স্ট্রীম ব্যবহার করার নিয়মগুলিকে কভার করে৷ একটি উল্লেখযোগ্য সংযোজনের সাথে, একই নিয়ম একাধিক ক্যামেরার জন্য প্রযোজ্য। CameraMetadata.REQUEST_AVAILABLE_CAPABILITIES_LOGICAL_MULTI_CAMERA ব্যাখ্যা করে কিভাবে একটি যৌক্তিক YUV_420_888 বা কাঁচা স্ট্রীম দুটি ফিজিক্যাল স্ট্রিম দিয়ে প্রতিস্থাপন করা যায়। অর্থাৎ, YUV বা RAW টাইপের প্রতিটি স্ট্রীম অভিন্ন টাইপ এবং আকারের দুটি স্ট্রিম দিয়ে প্রতিস্থাপন করা যেতে পারে। আপনি একক-ক্যামেরা ডিভাইসের জন্য নিম্নলিখিত গ্যারান্টিযুক্ত কনফিগারেশনের একটি ক্যামেরা স্ট্রিম দিয়ে শুরু করতে পারেন:

- স্ট্রীম 1: YUV প্রকার, লজিক্যাল ক্যামেরা

id = 0থেকেMAXIMUMআকার

তারপরে, মাল্টি-ক্যামেরা সমর্থন সহ একটি ডিভাইস আপনাকে দুটি ফিজিক্যাল স্ট্রিমের সাথে সেই লজিক্যাল YUV স্ট্রীম প্রতিস্থাপন করে একটি সেশন তৈরি করতে দেয়:

- স্ট্রীম 1: YUV প্রকার, ফিজিক্যাল ক্যামেরা

id = 1থেকেMAXIMUMআকার - স্ট্রীম 2: YUV প্রকার, ফিজিক্যাল ক্যামেরা

id = 2থেকেMAXIMUMআকার

আপনি একটি YUV বা RAW স্ট্রীম দুটি সমতুল্য স্ট্রীম দিয়ে প্রতিস্থাপন করতে পারেন যদি এবং শুধুমাত্র যদি এই দুটি ক্যামেরা একটি লজিক্যাল ক্যামেরা গ্রুপিংয়ের অংশ হয়, যা CameraCharacteristics.getPhysicalCameraIds() এর অধীনে তালিকাভুক্ত হয়।

ফ্রেমওয়ার্ক দ্বারা প্রদত্ত গ্যারান্টিগুলি একই সাথে একাধিক ফিজিক্যাল ক্যামেরা থেকে ফ্রেম পেতে প্রয়োজনীয় নূন্যতম। অতিরিক্ত স্ট্রীমগুলি বেশিরভাগ ডিভাইসে সমর্থিত, কখনও কখনও এমনকি একাধিক শারীরিক ক্যামেরা ডিভাইস স্বাধীনভাবে খোলার অনুমতি দেয়। যেহেতু এটি ফ্রেমওয়ার্ক থেকে একটি কঠিন গ্যারান্টি নয়, তাই এটি করার জন্য প্রতি-ডিভাইস পরীক্ষা করা এবং ট্রায়াল এবং ত্রুটি ব্যবহার করে টিউনিং করা প্রয়োজন।

একাধিক ফিজিক্যাল ক্যামেরা সহ একটি সেশন তৈরি করা

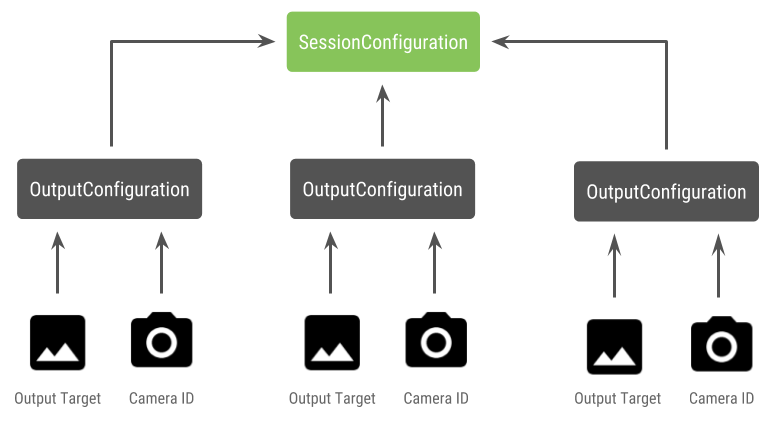

মাল্টি-ক্যামেরা সক্ষম ডিভাইসে ফিজিক্যাল ক্যামেরা ব্যবহার করার সময়, একটি একক CameraDevice (লজিক্যাল ক্যামেরা) খুলুন এবং একটি একক সেশনের মধ্যে এটির সাথে ইন্টারঅ্যাক্ট করুন। API CameraDevice.createCaptureSession(SessionConfiguration config) ব্যবহার করে একক সেশন তৈরি করুন, যা API লেভেল 28-এ যোগ করা হয়েছিল। সেশন কনফিগারেশনে অনেকগুলি আউটপুট কনফিগারেশন রয়েছে, যার প্রত্যেকটিতে আউটপুট লক্ষ্যগুলির একটি সেট এবং, ঐচ্ছিকভাবে, একটি পছন্দসই ফিজিক্যাল ক্যামেরা রয়েছে। আইডি

ক্যাপচার অনুরোধগুলির সাথে একটি আউটপুট লক্ষ্য যুক্ত রয়েছে। ফ্রেমওয়ার্ক নির্ধারণ করে কোন ফিজিক্যাল (বা লজিক্যাল) ক্যামেরায় কোন আউটপুট টার্গেট সংযুক্ত করা হয়েছে তার উপর ভিত্তি করে অনুরোধগুলো পাঠানো হয়েছে। যদি আউটপুট লক্ষ্য আউটপুট লক্ষ্যমাত্রাগুলির একটির সাথে মিলে যায় যা একটি ফিজিক্যাল ক্যামেরা আইডি সহ একটি আউটপুট কনফিগারেশন হিসাবে পাঠানো হয়েছিল, তাহলে সেই ফিজিক্যাল ক্যামেরা অনুরোধটি গ্রহণ করে এবং প্রক্রিয়া করে।

এক জোড়া ফিজিক্যাল ক্যামেরা ব্যবহার করা

মাল্টি-ক্যামেরার জন্য ক্যামেরা API-এর আরেকটি সংযোজন হল যৌক্তিক ক্যামেরা শনাক্ত করার এবং তাদের পিছনের ফিজিক্যাল ক্যামেরাগুলি খুঁজে বের করার ক্ষমতা। আপনি লজিক্যাল ক্যামেরা স্ট্রিমগুলির একটি প্রতিস্থাপন করতে ব্যবহার করতে পারেন এমন সম্ভাব্য জোড়া শারীরিক ক্যামেরা সনাক্ত করতে সাহায্য করার জন্য একটি ফাংশন সংজ্ঞায়িত করতে পারেন:

কোটলিন

/** * Helper class used to encapsulate a logical camera and two underlying * physical cameras */ data class DualCamera(val logicalId: String, val physicalId1: String, val physicalId2: String) fun findDualCameras(manager: CameraManager, facing: Int? = null): List{ val dualCameras = MutableList () // Iterate over all the available camera characteristics manager.cameraIdList.map { Pair(manager.getCameraCharacteristics(it), it) }.filter { // Filter by cameras facing the requested direction facing == null || it.first.get(CameraCharacteristics.LENS_FACING) == facing }.filter { // Filter by logical cameras // CameraCharacteristics.REQUEST_AVAILABLE_CAPABILITIES_LOGICAL_MULTI_CAMERA requires API >= 28 it.first.get(CameraCharacteristics.REQUEST_AVAILABLE_CAPABILITIES)!!.contains( CameraCharacteristics.REQUEST_AVAILABLE_CAPABILITIES_LOGICAL_MULTI_CAMERA) }.forEach { // All possible pairs from the list of physical cameras are valid results // NOTE: There could be N physical cameras as part of a logical camera grouping // getPhysicalCameraIds() requires API >= 28 val physicalCameras = it.first.physicalCameraIds.toTypedArray() for (idx1 in 0 until physicalCameras.size) { for (idx2 in (idx1 + 1) until physicalCameras.size) { dualCameras.add(DualCamera( it.second, physicalCameras[idx1], physicalCameras[idx2])) } } } return dualCameras }

জাভা

/** * Helper class used to encapsulate a logical camera and two underlying * physical cameras */ final class DualCamera { final String logicalId; final String physicalId1; final String physicalId2; DualCamera(String logicalId, String physicalId1, String physicalId2) { this.logicalId = logicalId; this.physicalId1 = physicalId1; this.physicalId2 = physicalId2; } } ListfindDualCameras(CameraManager manager, Integer facing) { List dualCameras = new ArrayList<>(); List cameraIdList; try { cameraIdList = Arrays.asList(manager.getCameraIdList()); } catch (CameraAccessException e) { e.printStackTrace(); cameraIdList = new ArrayList<>(); } // Iterate over all the available camera characteristics cameraIdList.stream() .map(id -> { try { CameraCharacteristics characteristics = manager.getCameraCharacteristics(id); return new Pair<>(characteristics, id); } catch (CameraAccessException e) { e.printStackTrace(); return null; } }) .filter(pair -> { // Filter by cameras facing the requested direction return (pair != null) && (facing == null || pair.first.get(CameraCharacteristics.LENS_FACING).equals(facing)); }) .filter(pair -> { // Filter by logical cameras // CameraCharacteristics.REQUEST_AVAILABLE_CAPABILITIES_LOGICAL_MULTI_CAMERA requires API >= 28 IntPredicate logicalMultiCameraPred = arg -> arg == CameraCharacteristics.REQUEST_AVAILABLE_CAPABILITIES_LOGICAL_MULTI_CAMERA; return Arrays.stream(pair.first.get(CameraCharacteristics.REQUEST_AVAILABLE_CAPABILITIES)) .anyMatch(logicalMultiCameraPred); }) .forEach(pair -> { // All possible pairs from the list of physical cameras are valid results // NOTE: There could be N physical cameras as part of a logical camera grouping // getPhysicalCameraIds() requires API >= 28 String[] physicalCameras = pair.first.getPhysicalCameraIds().toArray(new String[0]); for (int idx1 = 0; idx1 < physicalCameras.length; idx1++) { for (int idx2 = idx1 + 1; idx2 < physicalCameras.length; idx2++) { dualCameras.add( new DualCamera(pair.second, physicalCameras[idx1], physicalCameras[idx2])); } } }); return dualCameras; }

ফিজিক্যাল ক্যামেরার স্টেট হ্যান্ডলিং লজিক্যাল ক্যামেরা দ্বারা নিয়ন্ত্রিত হয়। একটি "দ্বৈত ক্যামেরা" খুলতে, ভৌত ক্যামেরার সাথে সম্পর্কিত লজিক্যাল ক্যামেরা খুলুন:

কোটলিন

fun openDualCamera(cameraManager: CameraManager, dualCamera: DualCamera, // AsyncTask is deprecated beginning API 30 executor: Executor = AsyncTask.SERIAL_EXECUTOR, callback: (CameraDevice) -> Unit) { // openCamera() requires API >= 28 cameraManager.openCamera( dualCamera.logicalId, executor, object : CameraDevice.StateCallback() { override fun onOpened(device: CameraDevice) = callback(device) // Omitting for brevity... override fun onError(device: CameraDevice, error: Int) = onDisconnected(device) override fun onDisconnected(device: CameraDevice) = device.close() }) }

জাভা

void openDualCamera(CameraManager cameraManager, DualCamera dualCamera, Executor executor, CameraDeviceCallback cameraDeviceCallback ) { // openCamera() requires API >= 28 cameraManager.openCamera(dualCamera.logicalId, executor, new CameraDevice.StateCallback() { @Override public void onOpened(@NonNull CameraDevice cameraDevice) { cameraDeviceCallback.callback(cameraDevice); } @Override public void onDisconnected(@NonNull CameraDevice cameraDevice) { cameraDevice.close(); } @Override public void onError(@NonNull CameraDevice cameraDevice, int i) { onDisconnected(cameraDevice); } }); }

কোন ক্যামেরা খুলতে হবে তা নির্বাচন করার পাশাপাশি, প্রক্রিয়াটি অতীতের অ্যান্ড্রয়েড সংস্করণগুলিতে একটি ক্যামেরা খোলার মতোই। নতুন সেশন কনফিগারেশন API ব্যবহার করে একটি ক্যাপচার সেশন তৈরি করা ফ্রেমওয়ার্ককে নির্দিষ্ট শারীরিক ক্যামেরা আইডিগুলির সাথে নির্দিষ্ট লক্ষ্যগুলিকে সংযুক্ত করতে বলে:

কোটলিন

/** * Helper type definition that encapsulates 3 sets of output targets: * * 1. Logical camera * 2. First physical camera * 3. Second physical camera */ typealias DualCameraOutputs = Triple<MutableList?, MutableList?, MutableList?> fun createDualCameraSession(cameraManager: CameraManager, dualCamera: DualCamera, targets: DualCameraOutputs, // AsyncTask is deprecated beginning API 30 executor: Executor = AsyncTask.SERIAL_EXECUTOR, callback: (CameraCaptureSession) -> Unit) { // Create 3 sets of output configurations: one for the logical camera, and // one for each of the physical cameras. val outputConfigsLogical = targets.first?.map { OutputConfiguration(it) } val outputConfigsPhysical1 = targets.second?.map { OutputConfiguration(it).apply { setPhysicalCameraId(dualCamera.physicalId1) } } val outputConfigsPhysical2 = targets.third?.map { OutputConfiguration(it).apply { setPhysicalCameraId(dualCamera.physicalId2) } } // Put all the output configurations into a single flat array val outputConfigsAll = arrayOf( outputConfigsLogical, outputConfigsPhysical1, outputConfigsPhysical2) .filterNotNull().flatMap { it } // Instantiate a session configuration that can be used to create a session val sessionConfiguration = SessionConfiguration( SessionConfiguration.SESSION_REGULAR, outputConfigsAll, executor, object : CameraCaptureSession.StateCallback() { override fun onConfigured(session: CameraCaptureSession) = callback(session) // Omitting for brevity... override fun onConfigureFailed(session: CameraCaptureSession) = session.device.close() }) // Open the logical camera using the previously defined function openDualCamera(cameraManager, dualCamera, executor = executor) { // Finally create the session and return via callback it.createCaptureSession(sessionConfiguration) } }

জাভা

/** * Helper class definition that encapsulates 3 sets of output targets: ** 1. Logical camera * 2. First physical camera * 3. Second physical camera */ final class DualCameraOutputs { private final List

logicalCamera; private final List firstPhysicalCamera; private final List secondPhysicalCamera; public DualCameraOutputs(List logicalCamera, List firstPhysicalCamera, List third) { this.logicalCamera = logicalCamera; this.firstPhysicalCamera = firstPhysicalCamera; this.secondPhysicalCamera = third; } public List getLogicalCamera() { return logicalCamera; } public List getFirstPhysicalCamera() { return firstPhysicalCamera; } public List getSecondPhysicalCamera() { return secondPhysicalCamera; } } interface CameraCaptureSessionCallback { void callback(CameraCaptureSession cameraCaptureSession); } void createDualCameraSession(CameraManager cameraManager, DualCamera dualCamera, DualCameraOutputs targets, Executor executor, CameraCaptureSessionCallback cameraCaptureSessionCallback) { // Create 3 sets of output configurations: one for the logical camera, and // one for each of the physical cameras. List outputConfigsLogical = targets.getLogicalCamera().stream() .map(OutputConfiguration::new) .collect(Collectors.toList()); List outputConfigsPhysical1 = targets.getFirstPhysicalCamera().stream() .map(s -> { OutputConfiguration outputConfiguration = new OutputConfiguration(s); outputConfiguration.setPhysicalCameraId(dualCamera.physicalId1); return outputConfiguration; }) .collect(Collectors.toList()); List outputConfigsPhysical2 = targets.getSecondPhysicalCamera().stream() .map(s -> { OutputConfiguration outputConfiguration = new OutputConfiguration(s); outputConfiguration.setPhysicalCameraId(dualCamera.physicalId2); return outputConfiguration; }) .collect(Collectors.toList()); // Put all the output configurations into a single flat array List outputConfigsAll = Stream.of( outputConfigsLogical, outputConfigsPhysical1, outputConfigsPhysical2 ) .filter(Objects::nonNull) .flatMap(Collection::stream) .collect(Collectors.toList()); // Instantiate a session configuration that can be used to create a session SessionConfiguration sessionConfiguration = new SessionConfiguration( SessionConfiguration.SESSION_REGULAR, outputConfigsAll, executor, new CameraCaptureSession.StateCallback() { @Override public void onConfigured(@NonNull CameraCaptureSession cameraCaptureSession) { cameraCaptureSessionCallback.callback(cameraCaptureSession); } // Omitting for brevity... @Override public void onConfigureFailed(@NonNull CameraCaptureSession cameraCaptureSession) { cameraCaptureSession.getDevice().close(); } }); // Open the logical camera using the previously defined function openDualCamera(cameraManager, dualCamera, executor, (CameraDevice c) -> // Finally create the session and return via callback c.createCaptureSession(sessionConfiguration)); }

স্ট্রীমগুলির কোন সমন্বয় সমর্থিত তা তথ্যের জন্য createCaptureSession দেখুন। একক লজিক্যাল ক্যামেরায় একাধিক স্ট্রীমের জন্য স্ট্রিমগুলিকে একত্রিত করা। সামঞ্জস্যতা একই কনফিগারেশন ব্যবহার করে এবং একই লজিক্যাল ক্যামেরার অংশ দুটি ফিজিক্যাল ক্যামেরা থেকে দুটি স্ট্রীম দিয়ে সেই স্ট্রিমগুলির একটিকে প্রতিস্থাপন করার জন্য প্রসারিত হয়৷

ক্যামেরা সেশন প্রস্তুত হলে, কাঙ্খিত ক্যাপচার অনুরোধগুলি প্রেরণ করুন। ক্যাপচার অনুরোধের প্রতিটি লক্ষ্য তার সম্পর্কিত ফিজিক্যাল ক্যামেরা থেকে ডেটা গ্রহণ করে, যদি কোনো ব্যবহার করা হয়, অথবা যৌক্তিক ক্যামেরায় ফিরে আসে।

জুম উদাহরণ ব্যবহার-কেস

এটি একটি একক স্ট্রীমে ভৌত ক্যামেরার একত্রীকরণ ব্যবহার করা সম্ভব যাতে ব্যবহারকারীরা একটি ভিন্ন ফিল্ড-অফ-ভিউ অনুভব করতে বিভিন্ন ফিজিক্যাল ক্যামেরার মধ্যে স্যুইচ করতে পারে, কার্যকরভাবে একটি ভিন্ন "জুম স্তর" ক্যাপচার করতে পারে।

ব্যবহারকারীদের মধ্যে স্যুইচ করার অনুমতি দেওয়ার জন্য ফিজিক্যাল ক্যামেরার জোড়া নির্বাচন করে শুরু করুন। সর্বাধিক প্রভাবের জন্য, আপনি ন্যূনতম এবং সর্বাধিক ফোকাল দৈর্ঘ্য উপলব্ধ ক্যামেরার জোড়া চয়ন করতে পারেন।

কোটলিন

fun findShortLongCameraPair(manager: CameraManager, facing: Int? = null): DualCamera? { return findDualCameras(manager, facing).map { val characteristics1 = manager.getCameraCharacteristics(it.physicalId1) val characteristics2 = manager.getCameraCharacteristics(it.physicalId2) // Query the focal lengths advertised by each physical camera val focalLengths1 = characteristics1.get( CameraCharacteristics.LENS_INFO_AVAILABLE_FOCAL_LENGTHS) ?: floatArrayOf(0F) val focalLengths2 = characteristics2.get( CameraCharacteristics.LENS_INFO_AVAILABLE_FOCAL_LENGTHS) ?: floatArrayOf(0F) // Compute the largest difference between min and max focal lengths between cameras val focalLengthsDiff1 = focalLengths2.maxOrNull()!! - focalLengths1.minOrNull()!! val focalLengthsDiff2 = focalLengths1.maxOrNull()!! - focalLengths2.minOrNull()!! // Return the pair of camera IDs and the difference between min and max focal lengths if (focalLengthsDiff1 < focalLengthsDiff2) { Pair(DualCamera(it.logicalId, it.physicalId1, it.physicalId2), focalLengthsDiff1) } else { Pair(DualCamera(it.logicalId, it.physicalId2, it.physicalId1), focalLengthsDiff2) } // Return only the pair with the largest difference, or null if no pairs are found }.maxByOrNull { it.second }?.first }

জাভা

// Utility functions to find min/max value in float[] float findMax(float[] array) { float max = Float.NEGATIVE_INFINITY; for(float cur: array) max = Math.max(max, cur); return max; } float findMin(float[] array) { float min = Float.NEGATIVE_INFINITY; for(float cur: array) min = Math.min(min, cur); return min; } DualCamera findShortLongCameraPair(CameraManager manager, Integer facing) { return findDualCameras(manager, facing).stream() .map(c -> { CameraCharacteristics characteristics1; CameraCharacteristics characteristics2; try { characteristics1 = manager.getCameraCharacteristics(c.physicalId1); characteristics2 = manager.getCameraCharacteristics(c.physicalId2); } catch (CameraAccessException e) { e.printStackTrace(); return null; } // Query the focal lengths advertised by each physical camera float[] focalLengths1 = characteristics1.get( CameraCharacteristics.LENS_INFO_AVAILABLE_FOCAL_LENGTHS); float[] focalLengths2 = characteristics2.get( CameraCharacteristics.LENS_INFO_AVAILABLE_FOCAL_LENGTHS); // Compute the largest difference between min and max focal lengths between cameras Float focalLengthsDiff1 = findMax(focalLengths2) - findMin(focalLengths1); Float focalLengthsDiff2 = findMax(focalLengths1) - findMin(focalLengths2); // Return the pair of camera IDs and the difference between min and max focal lengths if (focalLengthsDiff1 < focalLengthsDiff2) { return new Pair<>(new DualCamera(c.logicalId, c.physicalId1, c.physicalId2), focalLengthsDiff1); } else { return new Pair<>(new DualCamera(c.logicalId, c.physicalId2, c.physicalId1), focalLengthsDiff2); } }) // Return only the pair with the largest difference, or null if no pairs are found .max(Comparator.comparing(pair -> pair.second)).get().first; }

এর জন্য একটি বোধগম্য আর্কিটেকচার হবে দুটি SurfaceViews - প্রতিটি স্ট্রিমের জন্য একটি। এই SurfaceViews ব্যবহারকারীর ইন্টারঅ্যাকশনের উপর ভিত্তি করে অদলবদল করা হয় যাতে যে কোনো সময়ে শুধুমাত্র একটি দৃশ্যমান হয়।

নিম্নলিখিত কোডটি দেখায় কিভাবে লজিক্যাল ক্যামেরা খুলতে হয়, ক্যামেরা আউটপুট কনফিগার করতে হয়, একটি ক্যামেরা সেশন তৈরি করতে হয় এবং দুটি প্রিভিউ স্ট্রীম শুরু করতে হয়:

কোটলিন

val cameraManager: CameraManager = ... // Get the two output targets from the activity / fragment val surface1 = ... // from SurfaceView val surface2 = ... // from SurfaceView val dualCamera = findShortLongCameraPair(manager)!! val outputTargets = DualCameraOutputs( null, mutableListOf(surface1), mutableListOf(surface2)) // Here you open the logical camera, configure the outputs and create a session createDualCameraSession(manager, dualCamera, targets = outputTargets) { session -> // Create a single request which has one target for each physical camera // NOTE: Each target receive frames from only its associated physical camera val requestTemplate = CameraDevice.TEMPLATE_PREVIEW val captureRequest = session.device.createCaptureRequest(requestTemplate).apply { arrayOf(surface1, surface2).forEach { addTarget(it) } }.build() // Set the sticky request for the session and you are done session.setRepeatingRequest(captureRequest, null, null) }

জাভা

CameraManager manager = ...; // Get the two output targets from the activity / fragment Surface surface1 = ...; // from SurfaceView Surface surface2 = ...; // from SurfaceView DualCamera dualCamera = findShortLongCameraPair(manager, null); DualCameraOutputs outputTargets = new DualCameraOutputs( null, Collections.singletonList(surface1), Collections.singletonList(surface2)); // Here you open the logical camera, configure the outputs and create a session createDualCameraSession(manager, dualCamera, outputTargets, null, (session) -> { // Create a single request which has one target for each physical camera // NOTE: Each target receive frames from only its associated physical camera CaptureRequest.Builder captureRequestBuilder; try { captureRequestBuilder = session.getDevice().createCaptureRequest(CameraDevice.TEMPLATE_PREVIEW); Arrays.asList(surface1, surface2).forEach(captureRequestBuilder::addTarget); // Set the sticky request for the session and you are done session.setRepeatingRequest(captureRequestBuilder.build(), null, null); } catch (CameraAccessException e) { e.printStackTrace(); } });

ব্যবহারকারীর জন্য দুটি পৃষ্ঠের মধ্যে স্যুইচ করার জন্য একটি UI প্রদান করা বাকি আছে, যেমন একটি বোতাম বা SurfaceView ডবল-ট্যাপ করা। এমনকি আপনি দৃশ্য বিশ্লেষণের কিছু ফর্ম সঞ্চালন করতে পারেন এবং স্বয়ংক্রিয়ভাবে দুটি স্ট্রিমের মধ্যে স্যুইচ করতে পারেন।

লেন্স বিকৃতি

সমস্ত লেন্স একটি নির্দিষ্ট পরিমাণ বিকৃতি উত্পাদন করে। অ্যান্ড্রয়েডে, আপনি CameraCharacteristics.LENS_DISTORTION ব্যবহার করে লেন্স দ্বারা তৈরি বিকৃতির বিষয়ে প্রশ্ন করতে পারেন। LENS_DISTORTION , যা এখন অবচ্যুত CameraCharacteristics.LENS_RADIAL_DISTORTION প্রতিস্থাপন করে। LENS_RADIAL_DISTORTION। যৌক্তিক ক্যামেরাগুলির জন্য, বিকৃতিটি ন্যূনতম এবং আপনার অ্যাপ্লিকেশন ক্যামেরা থেকে আসা ফ্রেমগুলিকে কম বা বেশি ব্যবহার করতে পারে৷ ফিজিক্যাল ক্যামেরার জন্য, বিশেষত প্রশস্ত লেন্সগুলিতে সম্ভাব্য খুব ভিন্ন লেন্স কনফিগারেশন রয়েছে।

কিছু ডিভাইস CaptureRequest.DISTORTION_CORRECTION_MODE এর মাধ্যমে স্বয়ংক্রিয় বিকৃতি সংশোধন বাস্তবায়ন করতে পারে। বেশিরভাগ ডিভাইসের জন্য বিকৃতি সংশোধন ডিফল্ট চালু আছে।

কোটলিন

val cameraSession: CameraCaptureSession = ... // Use still capture template to build the capture request val captureRequest = cameraSession.device.createCaptureRequest( CameraDevice.TEMPLATE_STILL_CAPTURE ) // Determine if this device supports distortion correction val characteristics: CameraCharacteristics = ... val supportsDistortionCorrection = characteristics.get( CameraCharacteristics.DISTORTION_CORRECTION_AVAILABLE_MODES )?.contains( CameraMetadata.DISTORTION_CORRECTION_MODE_HIGH_QUALITY ) ?: false if (supportsDistortionCorrection) { captureRequest.set( CaptureRequest.DISTORTION_CORRECTION_MODE, CameraMetadata.DISTORTION_CORRECTION_MODE_HIGH_QUALITY ) } // Add output target, set other capture request parameters... // Dispatch the capture request cameraSession.capture(captureRequest.build(), ...)

জাভা

CameraCaptureSession cameraSession = ...; // Use still capture template to build the capture request CaptureRequest.Builder captureRequestBuilder = null; try { captureRequestBuilder = cameraSession.getDevice().createCaptureRequest( CameraDevice.TEMPLATE_STILL_CAPTURE ); } catch (CameraAccessException e) { e.printStackTrace(); } // Determine if this device supports distortion correction CameraCharacteristics characteristics = ...; boolean supportsDistortionCorrection = Arrays.stream( characteristics.get( CameraCharacteristics.DISTORTION_CORRECTION_AVAILABLE_MODES )) .anyMatch(i -> i == CameraMetadata.DISTORTION_CORRECTION_MODE_HIGH_QUALITY); if (supportsDistortionCorrection) { captureRequestBuilder.set( CaptureRequest.DISTORTION_CORRECTION_MODE, CameraMetadata.DISTORTION_CORRECTION_MODE_HIGH_QUALITY ); } // Add output target, set other capture request parameters... // Dispatch the capture request cameraSession.capture(captureRequestBuilder.build(), ...);

এই মোডে একটি ক্যাপচার অনুরোধ সেট করা ক্যামেরা দ্বারা উত্পাদিত ফ্রেম হারকে প্রভাবিত করতে পারে। আপনি শুধুমাত্র স্থির চিত্র ক্যাপচারে বিকৃতি সংশোধন সেট করতে পারেন।