大型語言模型 (LLM) 的功能各不相同。為讓您在 AI 輔助軟體開發過程中享有控制權和彈性,Android Studio 可讓您選擇在本機上執行的本機模型,為 IDE 的 AI 功能提供支援。

選擇模型

本機模型可做為 Android Studio 內建 LLM 支援的替代方案;不過,Android Studio 中的 Gemini 通常會提供最佳的 Android 開發人員 AI 體驗,因為它採用強大的 Gemini 模型。您可以為 Android 開發工作選用各種 Gemini 模型,包括免付費的預設模型,或是透過付費 Gemini API 金鑰存取的模型。

如果您需要離線工作、必須遵守公司對 AI 工具使用的嚴格政策,或是想試用開放原始碼研究模型,就很適合使用本機模型功能。

設定本機模型支援

將模型供應商新增至 Android Studio。

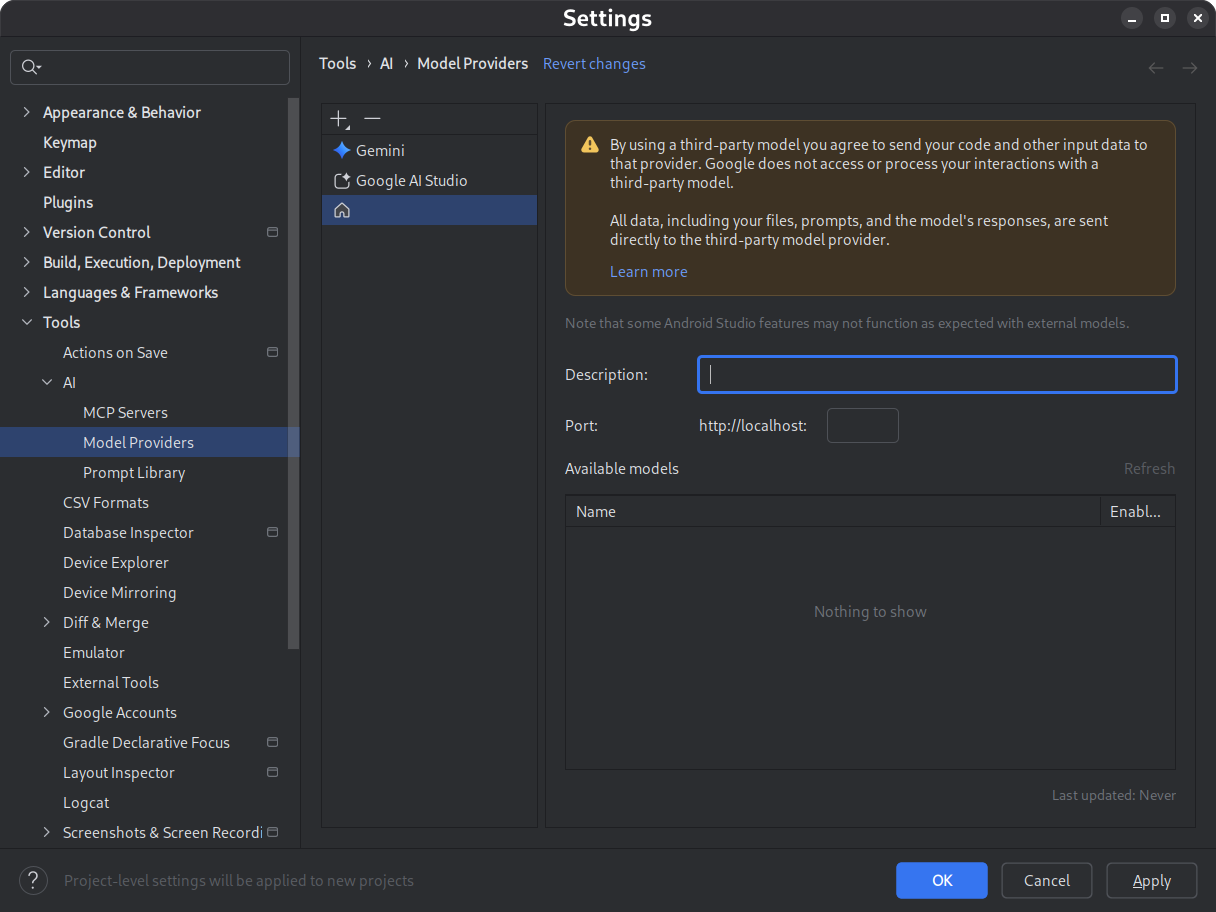

- 依序前往「設定」>「工具」>「AI」>「模型供應商」

- 選取「」圖示

- 選取「Local Provider」

- 輸入模型供應商的說明 (通常是模型供應商的名稱)

- 設定供應商監聽的通訊埠

- 啟用模型

圖 1. 模型供應商設定。 下載並安裝所選模型。

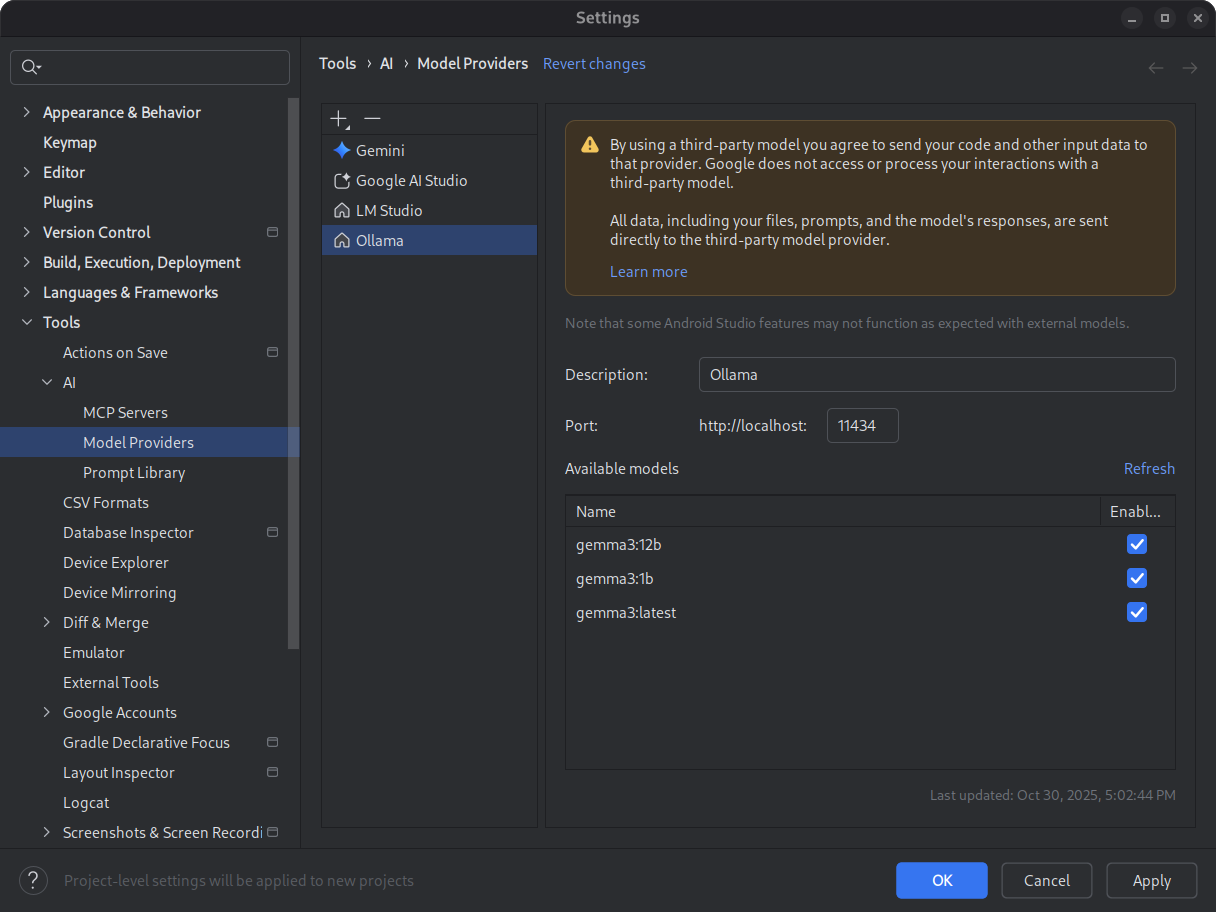

請參閱 LM Studio 和 Ollama 模型目錄。如要在 Android Studio 中獲得最佳的代理程式模式體驗,請選取已接受工具使用訓練的模型。

圖 2. 可用的本機模型。 啟動推論環境。

推論環境會將模型提供給本機應用程式。設定足夠大的脈絡長度權杖視窗,以獲得最佳效能。如需啟動及設定環境的詳細操作說明,請參閱 Ollama 或 LM Studio 說明文件。

選取模型。

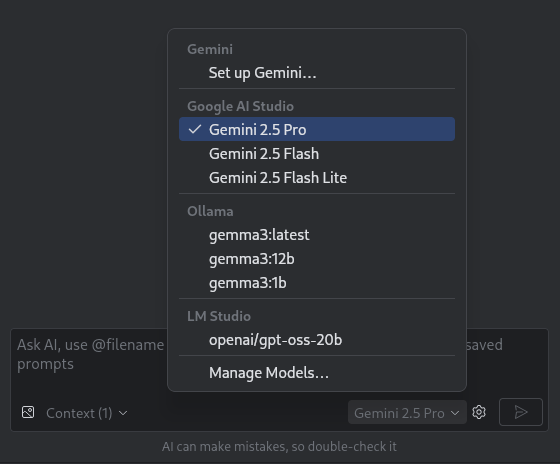

開啟 Android Studio。前往 Gemini 對話視窗。使用模型挑選器,從預設的 Gemini 模型切換至設定的本機模型。

圖 3. 模型挑選器。

將 Android Studio 連線至本機模型後,您就可以在 IDE 中使用即時通訊功能。所有互動完全由在本機執行的模型提供支援,為您提供獨立的 AI 開發環境。

考慮效能限制

本機離線模型通常不會像雲端 Gemini 模型一樣高效或智慧。與雲端模型相比,本機模型產生的對話回覆通常較不準確,延遲時間也較長。

本機模型通常不會針對 Android 開發作業進行微調,而且本機模型可能會傳回與 Android Studio 使用者介面無關的回應。使用本機模型時,部分 Android Studio AI 功能和 Android 開發用途無法運作。不過,Android Studio 的 AI 即時通訊功能通常是由本機模型支援。

如要快速取得有關 Android 開發各方面的準確回覆,並支援所有 Android Studio 功能,Gemini 版 Android Studio (由 Gemini 模型提供技術支援) 是最佳解決方案。