Os modelos de linguagem grandes (LLMs) têm capacidades diferentes. Para oferecer controle e flexibilidade no desenvolvimento de software assistido por IA, o Android Studio permite escolher um modelo local, executado na sua máquina pessoal, para ativar a funcionalidade de IA do IDE.

Escolher um modelo

Um modelo local oferece uma alternativa ao suporte a LLM integrado ao Android Studio. No entanto, o Gemini no Android Studio geralmente oferece a melhor experiência de IA para desenvolvedores Android devido aos poderosos modelos do Gemini. Você pode escolher entre vários modelos do Gemini para suas tarefas de desenvolvimento do Android, incluindo o modelo padrão sem custo financeiro ou modelos acessados com uma chave de API Gemini paga.

A capacidade de modelo local é uma ótima opção se você precisa trabalhar off-line, seguir políticas rígidas da empresa sobre o uso de ferramentas de IA ou quer testar modelos de pesquisa de código aberto.

Configurar o suporte a modelos locais

Baixe e instale a versão canary mais recente do Android Studio.

Instale um provedor de LLM, como o LM Studio ou o Ollama, no seu computador local.

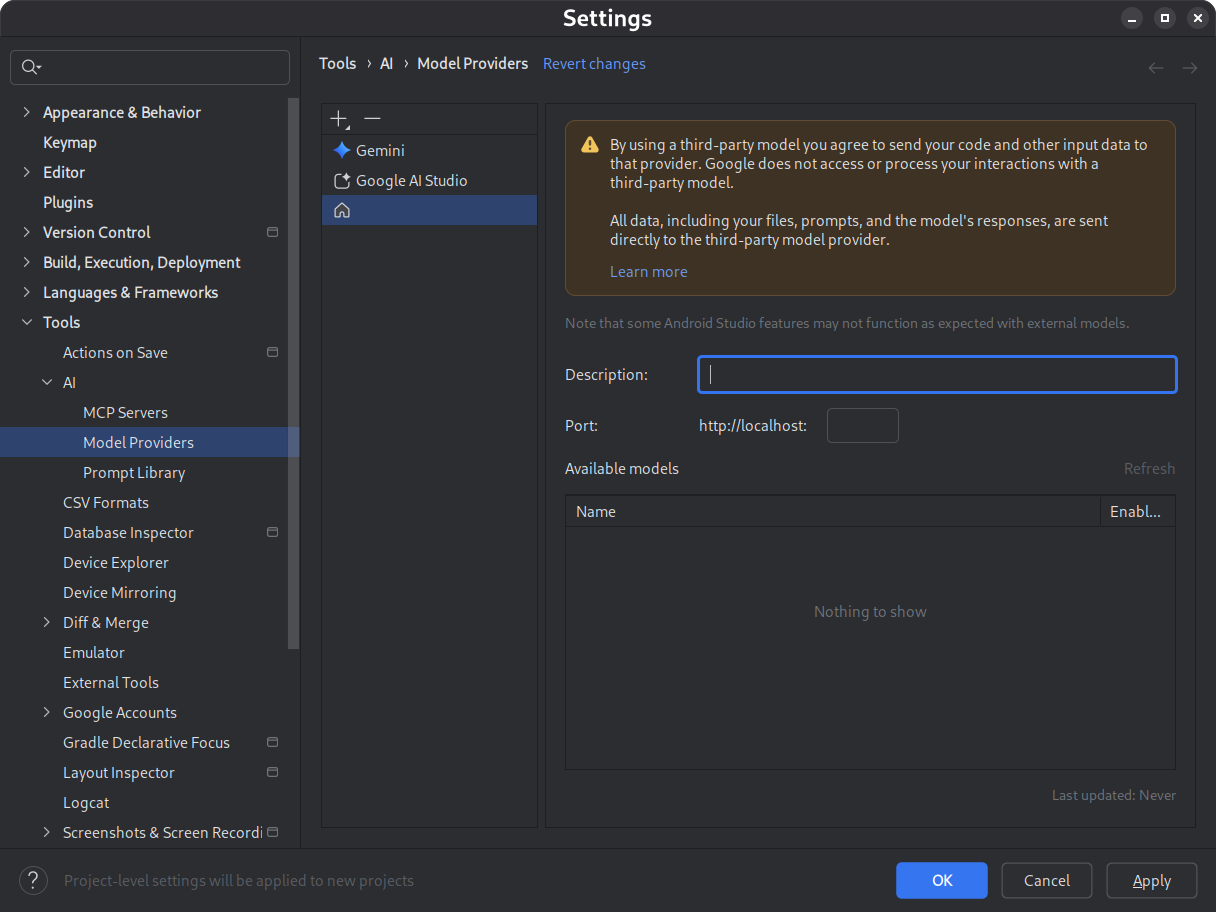

Adicione o provedor de modelos ao Android Studio.

- Acesse Configurações > Ferramentas > IA > Provedores de modelos

- Selecione o ícone .

- Selecione Provedor local.

- Insira uma descrição do provedor do modelo (normalmente o nome do provedor).

- Definir a porta em que o provedor está escutando

- Ativar um modelo

Figura 1. Configurações do provedor de modelo. Baixe e instale um modelo de sua escolha.

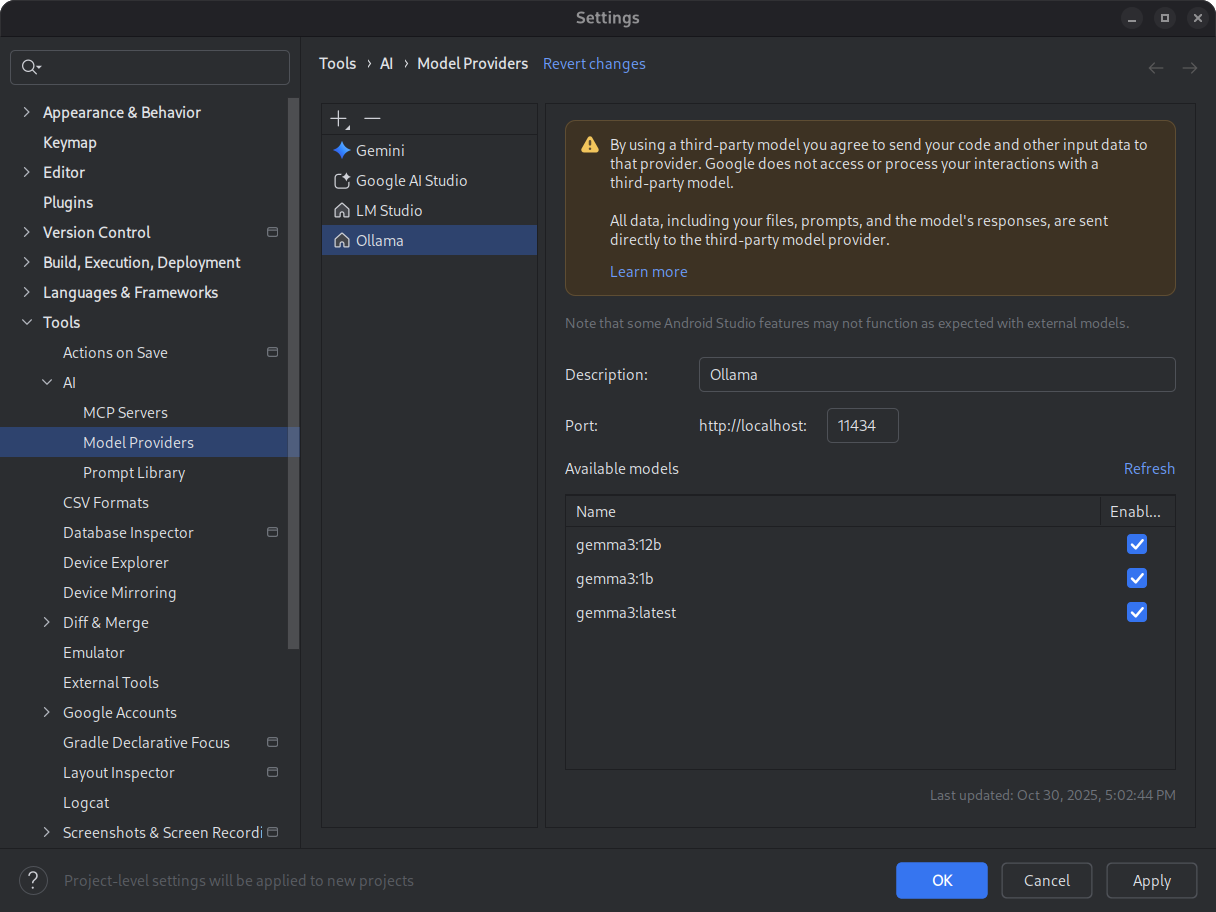

Consulte os catálogos de modelos do LM Studio e do Ollama. Para ter a melhor experiência com o modo agente no Android Studio, selecione um modelo treinado para uso de ferramentas.

Figura 2. Modelos locais disponíveis. Inicie o ambiente de inferência.

O ambiente de inferência veicula seu modelo para aplicativos locais. Configure uma janela de token de comprimento de contexto suficientemente grande para ter uma performance ideal. Para instruções detalhadas sobre como iniciar e configurar seu ambiente, consulte a documentação do Ollama ou do LM Studio.

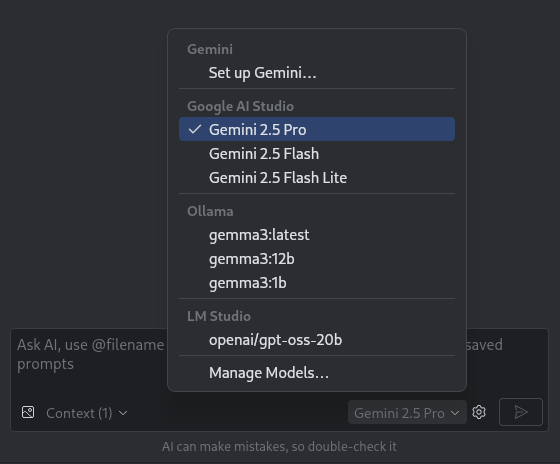

Selecione um modelo.

Abra o Android Studio. Navegue até a janela de conversa no Gemini. Use o seletor de modelos para mudar do modelo Gemini padrão para o modelo local configurado.

Figura 3. Seletor de modelos.

Depois de conectar o Android Studio ao seu modelo local, você pode usar os recursos de chat no ambiente de desenvolvimento integrado. Todas as interações são totalmente alimentadas pelo modelo executado na sua máquina local, oferecendo um ambiente de desenvolvimento de IA autônomo.

Considerar limitações de desempenho

Um modelo local e off-line geralmente não tem o mesmo desempenho ou inteligência dos modelos do Gemini baseados na nuvem. As respostas do chat de modelos locais geralmente são menos precisas e têm maior latência em comparação com modelos baseados na nuvem.

Os modelos locais geralmente não são ajustados para desenvolvimento do Android, e eles podem retornar respostas que não têm informações sobre a interface do usuário do Android Studio. Alguns recursos de IA do Android Studio e casos de uso de desenvolvimento do Android não funcionam com um modelo local. No entanto, o recurso de chat com IA no Android Studio geralmente é compatível com modelos locais.

Para respostas rápidas e precisas sobre todos os aspectos do desenvolvimento do Android e suporte para todos os recursos do Android Studio, o Gemini no Android Studio, com tecnologia dos modelos do Gemini, é a melhor solução.