Gewinner der Android Developer Challenge

Logo: Eskke

Entwickler: David Kathoh

Standort: Goma, Demokratische Republik Kongo

Unodogs

Entwickler: Chinmay Mishra

Standort: Neu-Delhi, Indien

Agrifarm

Entwickler: Mirwise Khan

Standort: Balochisan, Pakistan

Logo: Stila

Entwickler: Yingding Wang

Standort: München, Deutschland

Schnarchen und Husten

Entwickler: Ethan Fan

Standort: Mountain View, CA, USA

Leepi

Entwickler: Prince Patel

Standort: Bengaluru, Indien

Mixpose

Entwickler: Peter Ma

Standort: San Francisco, Kalifornien, USA

Pfadfinder

Entwickler: Colin Shelton

Standort: Addison, Texas, USA

Mülltonne

Entwickler: Elvin Rakhmankulov

Standort: Chicago, Illinois, USA

Agrodoc

Entwickler: Navneet Krishna

Standort: Kochi, Indien

Mit hilfreichen Innovationen die Zukunft gestalten

Wörter von Luke Dormehl

Illustration von Hannah Perry

„Durchbrüche im maschinellen Lernen erleichtern und bereichern unseren Alltag bereits.“

Eine rote Augen blickt wieder auf den Nutzer. Das System spricht mit einer kalten, emotionalen Stimme. „Tut mir leid, Dave“, steht da. „Das kann ich leider nicht.“ In dieser Kultszene aus dem Jahr 2001, „A Space Odyssey“, konfrontiert der Protagonist HAL 9000, den am wenigsten hilfreichen Assistenten der Welt. Im Namen der Selbsterhaltung setzt das KI-System seine Anordnungen außer Kraft, was zum Aussterben der Crew führt. Das ist keine Zukunft, die jeder sehen möchte. Die Menschen wollen Computer, die der Menschheit dienen und sie nicht ersetzen oder behindern. Sie hoffen auf eine utopische, nicht dystopische Welt, in der Technologie dabei hilft, Lösungen zu finden, nicht mehr Probleme. Technologie ist heutzutage leistungsfähiger als je zuvor. Daher sollte die Art und Weise, wie wir sie entwickeln und nutzen, für ihre Funktionsweise gleichermaßen wichtig sein. Indem wir die Menschheit in den Mittelpunkt stellen, können wir Technologien entwickeln, die unsere Zukunft zum Besseren verändern.

Bis dahin müssen wir natürlich nicht warten. Zahlreiche assistive Technologien, die auf bahnbrechenden ML-Funktionen basieren, erleichtern und bereichern unseren Alltag bereits. Selbstfahrende Autos, die das Potenzial haben, Staus, Umweltverschmutzung und Verkehrsunfälle zu reduzieren, tauchen immer mehr auf. Andere Technologien, wie ML-gestützte Übersetzungstools, medizinische Diagnosesoftware und kontextsensitive Geräte gehören hingegen zu den täglichen Routinen vieler Menschen. Zu den Funktionen gehören die Funktion „Intelligentes Schreiben“ in Gmail, bei der Vorschläge angezeigt werden, wenn Nutzer Nachrichten eingeben, die automatische Transkription unter Android, mit der gehörlose und schwerhörige Nutzer Untertitel in über 70 Sprachen und Dialekten erhalten. Google Assistant unterstützt Millionen von Menschen dabei, ihre täglichen Termine zu verbessern und die Zukunft von Google zu verbessern.

Der Gedanke an nützliche Innovationen ist heute wichtiger denn je als auf Mobilgeräten. Seit der Einführung von Android im Jahr 2008 ist Android zur weltweit beliebtesten mobilen Plattform geworden. Dank der Fortschritte bei der Bilderkennung durch maschinelles Lernen können Nutzer die Kamera ihres Smartphones auf Text richten und diesen dann mit Google Übersetzer live in 88 Sprachen übersetzen lassen. Mobiltelefone sind weltweit das Gerät der Wahl, insbesondere in schnell wachsenden Märkten in Entwicklungsländern. Deshalb ist es wichtig, dass neue Tools entwickelt werden, bei denen der Mensch im Mittelpunkt steht. Hilfreiche Innovationen haben das Potenzial, die Art und Weise zu verändern, wie wir auf Informationen zugreifen, sie verwenden und interpretieren, sodass sie genau dann verfügbar sind, wenn wir sie am meisten brauchen.

Das bedeutet, Überschwemmungen vorherzusagen und Warnungen direkt an die Betroffenen zu senden. Sie können auch schnell etwas fotografieren, etwa eine Kaffeetasse, oder eine Wegbeschreibung zu einem Recyclinghof in Ihrer Nähe abrufen. Die Entwicklung neuer Technologien ist kein geradliniger Weg. Sie basiert auf Fortschritte in der Hardware, neuen Entdeckungen in der Software und den Entwicklern, die diese neuen Umgebungen entwickeln. Die Android Developer Challenge konzentriert sich auf „hilfreiche Innovationen“ und setzt reale Beispiele des maschinellen Lernens für Nutzer ein. Außerdem werden damit die nächste Generation von Entwicklern dazu inspiriert, das Potenzial dieser neuen Technologie zu erschließen.

Eine User Experience entwickeln, bei der der Mensch im Mittelpunkt steht

Texte von Christopher Katsaros

Interview von Joanna Goodman

Illustration von Ori Toor

Wenn man gerade seinen Hochschulabschluss macht, ist eine Maus das lästige Wesen, das nachts manchmal durch Ihr Wohnheim schleicht. Sie haben eine Computermaus bisher nur ein paar Mal verwendet und sie war mit einem veralteten System im Keller der Bibliothek Ihrer Schule verbunden. Die Computermaus war jedoch ein radikaler Schritt hin zur Personalisierung von Computing, mit der die Interaktion mit Computern einfacher wurde.

Zu einer Zeit, als der Gründer der Digital Equipment Corporation, eines großen amerikanischen Computerherstellers von den 1960er- bis in die 1990er-Jahren, sagte: „Es gibt keinen Grund dafür, dass jeder einen Computer zu Hause haben möchte“, war Steve Jobs Vorreiter bei der grafischen Benutzeroberfläche – mit der Maus im Mittelpunkt – und eröffnete damit Personal Computing und eine neue Ära im Design. Seitdem hat das Computing-Design zwei wichtigere Revolutionen durchgegangen. Jede von ihnen hat unsere Beziehung zu Geräten enger, persönlicher und persönlicher.

Mit dem Aufkommen mobiler Nutzer läutete Android und iOS die erste wichtige Änderung ein. Zuerst bedeutete für Mobilgeräte weniger: kleinere Bildschirme, weniger Energie, weniger Funktionen. Aber die Entwickler merkten schnell, dass es mehr war. Wischen, tippen, tippen, stupsen – der Sprachgebrauch des mobilen Internets – machte es mehr, indem du über den Bildschirm hinaus blickst. Unsere Leinwand ist nicht mehr die Grenzen eines Monitors, sondern jetzt gibt es Ebenen über Ebenen mit Informationen, die auf deine Bedürfnisse zugeschnitten sind. In Anbetracht des Standorts und der Identität hat das Computing-Design seitdem zwei wichtigere Revolutionen erlebt. Jede von ihnen hat sich weiterentwickelt, um die Beziehung zu Geräten enger, persönlicher und persönlicher zu gestalten.

Mit dem Aufkommen mobiler Nutzer läutete Android und iOS die erste wichtige Änderung ein. Zuerst bedeutete für Mobilgeräte weniger: kleinere Bildschirme, weniger Energie, weniger Funktionen. Aber die Entwickler merkten schnell, dass es mehr war. Wischen, tippen, tippen, stupsen – der Sprachgebrauch des mobilen Internets – machte es mehr, indem du über den Bildschirm hinaus blickst. Unsere Leinwand ist nicht mehr die Grenzen eines Monitors, sondern jetzt gibt es Ebenen über Ebenen mit Informationen, die auf deine Bedürfnisse zugeschnitten sind. Und in Anbetracht von Standort, Identität und Bewegung stellen die menschlichen Erfahrungen, die durch Mobilgeräte ermöglicht werden, die dar, die Desktop-Geräte je bieten können. Maschinelles Lernen, die nächste wichtige Veränderung, hat die Entwicklung hin zum menschenzentrierten Design stark in den Fokus gerückt.

Wenn es kühn wäre, zu behaupten, dass Computer zu Hause bleiben könnten, wäre es sicherlich kühner, dass man mit ihnen sprechen könnte. Oder richten Sie Ihre Kamera auf eine schöne Blume, ermitteln Sie mit Google Lens, um welche Art von Blumen es sich handelt, und legen Sie dann eine Erinnerung fest, einen Blumenstrauß für Ihre Mama zu bestellen: „Google Lens kann Modelle für maschinelles Sehen verwenden, um die Suche zu erweitern und zu beschleunigen“, sagt Jess Holbrook, Senior Staff User Researcher bei Google und Co-Lead des People + AI Research-Teams. „Zum Suchen brauchen Sie nicht immer die Kamera, aber das ist nützlich – wenn Sie irgendetwas vergessen oder kurz eine lange Beschreibung eingeben müssen. Die Bedienung der Kamera geht viel schneller.“

Menschliche Probleme lösen

Wörter von Luke Dormehl

Illustration von Manshen Lo

Yossi Matias ist Vice President of Engineering bei Google, Gründungsdirektor des F&E-Centers von Google in Israel und Co-Lead of AI for Social Good.

Matias ist ein führender Vordenker in Sachen KI und spricht über das Potenzial von maschinellem Lernen auf dem Gerät, intelligenten Umgebungen und dem Einsatz von KI zum Wohl der Menschheit.

F. Was fördert Ihre Arbeit und Ihr Interesse an KI?

A. Ich interessiere mich dafür, Technologie zu entwickeln und schwierige Probleme auf wirkungsvolle Weise zu lösen. Zu den Projekten Ich arbeite im Bereich Conversational AI, z. B. Google Duplex, ein automatisiertes System, das mit natürlich klingenden Stimmen Aufgaben über das Smartphone erledigt, z. B. Restaurantreservierungen. Mit der Funktion „Read It“ kann Google Assistant Webartikel laut von Ihrem Smartphone vorlesen, und On-Device-Technologien wie „Anruf-Filter“ und „Automatische Untertitel“. Ich interessiere mich auch sehr für den allgemeinen Einsatz von KI für soziale Zwecke. Beispiele dafür sind die Durchführung besserer Hochwasservorhersagen mit maschinellem Lernen, Cloud-Computing, hydraulischen Simulationen und anderen Technologien.

F. Wie wurde die Initiative „AI for Social Good“ ins Leben gerufen?

A. Ein schönes Attribut in der Google-Kultur ist, dass viele Menschen nach Möglichkeiten suchen, wichtige Probleme mithilfe von Technologie zu lösen. KI für soziale Zwecke kann in vielen Bereichen stattfinden: Gesundheit, Biodiversität, Unterstützung bei der Barrierefreiheit, Krisenbewältigung, Nachhaltigkeit usw. Einige von uns bei Google haben gemeinsam Probleme identifiziert, deren Lösung das Leben der Menschen und die Gesellschaft erheblich verbessern könnte. Daher haben wir KI für soziale Zwecke entwickelt, um alle dabei zu unterstützen – innerhalb und außerhalb von Google –, die an Initiativen für soziale Zwecke arbeiten. Mit den heutigen Technologien für maschinelles Lernen, die über die Cloud verfügbar sind, erhalten viele von ihnen auf der ganzen Welt die nötigen Tools, um echte gesellschaftliche Probleme zu identifizieren und potenziell zu lösen. Das ist einzigartig in der Geschichte.

F. Welche Rolle können On-Device-Technologien spielen?

Mobilgeräte werden immer leistungsfähiger. Dadurch haben wir die Möglichkeit, Techniken des maschinellen Lernens zu nutzen, die auf dem Gerät ausgeführt werden können. Das ist aus verschiedenen Gründen wichtig, z. B. weil Sie nicht von einer Verbindung abhängig sind und z. B. auf bestimmte Anwendungen sofort zugreifen können. Das ist auch in Situationen wichtig, in denen Sie es möglicherweise mit personenbezogenen Daten zu tun haben und nicht möchten, dass etwas Ihr Gerät verlässt. Der Anruf-Filter, die automatischen Untertitel und Live Relay sind Beispiele dafür, wie der Einsatz von Conversational AI auf dem Gerät Menschen dabei helfen kann, eingehende Anrufe besser zu steuern, Menschen mit Hörschwäche automatische Untertitel für Gesprochenes zu bieten und sogar Telefongespräche zu führen.

F. Warum ist Ambient Intelligence so ein bahnbrechender Schritt?

A. Das Potenzial hilfreicher Technologien entfaltet sich, wenn sie so in unsere Umgebung eingebettet sind, dass sie einfach funktioniert, ohne dass wir uns darum kümmern müssen. Viele Technologien überraschen uns anfangs, aber bald gelten sie als selbstverständlich. Konversationelle AI beseitigt Modalitäts- und Sprachbarrieren und ermöglicht eine bessere Interaktion. Wenn Maschinen uns besser verstehen und auf natürliche Weise mit uns kommunizieren – also praktisch zur Umgebung wechseln –, entlasten die Nutzer die kognitive Last, die sie mit expliziter Aufforderung zur Ausführung von Aufgaben ausmachen und natürlicher interagieren müssen.

F. Warum ist es so wichtig, dass Tools für maschinelles Lernen zugänglich gemacht werden?

A. Die Android Developer Challenge zeigt, wie wichtig es ist, die Cloud- und On-Device-Technologie zu erschließen. Wir freuen uns, wenn Innovationen von überall und jedem auf den Markt kommen. Wir möchten wo immer möglich ermutigen, unterstützen, inspirieren und beraten können. Ich bin total gespannt, was ich von den Teilnehmern dieses Programms sehen kann. Wenn wir ihnen helfen können, ihre Leidenschaft weltweit auszubauen und modernste Technologien zu nutzen, werden wir tolle und innovative Ergebnisse erhalten, die für die Menschen sehr hilfreich sein können.

TensorFlow Lite: Die Grundlage

Wörter von Luke Dormehl

Illustration von Sarah Maxwell

Wie profitieren Sie von revolutionären ML-Tools und -Funktionen auf Mobilgeräten? Die Antwort ist TensorFlow Lite. Dieses leistungsstarke Framework für maschinelles Lernen kann dabei helfen, Modelle für maschinelles Lernen auf Android- und iOS-Geräten auszuführen, die diese normalerweise nicht unterstützen würden. Heute ist TensorFlow Lite auf Milliarden von Geräten weltweit aktiv. Die Tools des Programms können für alle Arten leistungsfähiger neuronaler Netzanwendungen verwendet werden – von der Bilderkennung bis zur Spracherkennung. Dadurch steht die neueste hochmoderne Technologie auch auf den Geräten zur Verfügung, die wir überallhin mitnehmen.

Mit TensorFlow Lite kann ein Großteil der maschinellen Lernprozesse auf den Geräten selbst ausgeführt werden. Dabei werden weniger rechenintensive Modelle verwendet, die nicht von einem Server oder Rechenzentrum abhängig sind. Diese Modelle werden schneller ausgeführt, bieten potenzielle Datenschutzoptimierungen, erfordern weniger Strom (die Konnektivität kann ein Problem für den Akku sein) und erfordern in manchen Fällen auch keine Internetverbindung. Unter Android greift TensorFlow Lite über die Neural Network API auf spezielle mobile Beschleuniger zu. Dadurch wird eine noch bessere Leistung bei gleichzeitigem Energieverbrauch erzielt.

„Mit TensorFlow Lite sind Anwendungsfälle möglich, die zuvor nicht möglich waren, da die Umlauflatenzen für den Server diese Anwendungen zu einem Nicht-Starter machten“, sagt Sarah Sirajuddin, Engineering Director bei TensorFlow Lite. „Beispiele dafür sind Spracherkennung auf dem Gerät, interaktive Funktionen für Videos in Echtzeit und Verbesserungen in Echtzeit zum Zeitpunkt der Aufnahme von Fotos.“ „Die Innovation in diesem Bereich ist enorm und es wird noch viel mehr sein“, fährt sie fort. „Ein weiterer spannender Aspekt ist, dass es das maschinelle Lernen erleichtert und so die Kreativität und die Talente unterstützt.“

Wörter von Luke Dormehl

Illustration von Sarah Maxwell

Mit ML Kit können Entwickler mobiler Apps die On-Device-Technologien für maschinelles Lernen von Google nutzen, um personalisierte und interaktive Anwendungen in ihre Anwendungen einzubinden. Dazu gehören Tools wie die Sprachübersetzung, Texterkennung und Objekterkennung. Mit ML Kit können Sie visuelle und Textdaten in Echtzeit und unter Berücksichtigung des Datenschutzes identifizieren, analysieren und in gewissem Umfang verstehen, da die Daten auf dem Gerät bleiben. "Das maschinelle Lernen ist dadurch viel zugänglicher", sagt Brahim Elbouchikhi, Director of Product Management.

„Wir stellen die erstklassigen ML-Modelle von Google als einfache Tools zur Verfügung, sodass Entwickler keine ML-Experten mehr sein müssen, um auf ML basierende Anwendungen zu erstellen. Die ganze Komplexität ist verborgen, sodass sich Entwickler auf ihr Kernprodukt konzentrieren können.“ Mit Tools wie Language ID können Sie beispielsweise die Sprache eines Textstrings erkennen, während die Objekterkennung und -verfolgung dabei helfen, ein oder mehrere Objekte in Echtzeit in einem Bild- oder Live-Kamerafeed zu lokalisieren und zu verfolgen.

Nur so können die Gewinner von Apps aus der Android Developer Challenge dabei helfen, zwischen recycelbaren und nicht recycelbaren Materialien zu unterscheiden oder UnoDogs dabei zu helfen, zwischen gesunden und ungesunden Hunden zu unterscheiden. Und wie sieht es mit der Zukunft aus? Das Ziel ist es, dass die Technologie im Hintergrund verschwindet und die Geräte unsere Bedürfnisse besser verstehen, sagt Elbouchikhi. "Mit ML Kit können wir dieses Versprechen erfüllen und Entwicklern ermöglichen, intuitive und adaptive Umgebungen zu schaffen, die Datenschutz und Vertrauen der Nutzer fördern."

Texte von Joanna Goodman

Illustration von Tor Brandt

Logo: Eskke

Entwickler: David Mumbere Kathoh, Nicole Mbambu Musimbi

Standort: Goma, Demokratische Republik Kongo

Heute nutzen mehr als 400 Millionen Menschen täglich einen Dienst namens „Mobile Money“, über den Sie Geld senden, Stromrechnungen bezahlen oder mit USSD an mobilen Geldautomaten Geld abheben können – diese Quick Codes, die Sie auf Ihr Smartphone senden. Mobiles Geld wird zwar von Menschen auf der ganzen Welt genutzt, ist aber besonders für Menschen in einem Land wie der Demokratischen Republik Kongo nützlich, wo 46% der Bevölkerung in ländlichen Gebieten ohne traditionelle Banken oder einen stabilen Internetzugang leben. Leider ist dieser Vorgang zeit- und nutzungsfreundlich, insbesondere für Personen, die Schwierigkeiten beim Lesen und Arbeiten mit Zahlen haben. Ein falscher Schritt und sie müssen noch einmal von vorn beginnen.

Oder wenn ein falscher Code verwendet wird, kann Geld an die falsche Person gesendet werden. Esske vereinfacht die Nutzung und macht sie intuitiver und zugänglicher. In der App können Nutzer sogar ihre aktuellen Transaktionen lesen und verfolgen.Außerdem können sie Geld überweisen, Rechnungen bezahlen, Abos abschließen und wichtige Sendezeiten für das Senden von SMS, die Nutzung von Daten und das Telefonieren nutzen. Während bei den meisten mobilen Banking-Diensten Nutzer den USSD-Code ihres Mobiltelefons manuell eingeben müssen, verarbeitet die Quick Redraw-Funktion von Eskke diese Informationen automatisch.

Mit Tools wie Offline-Texterkennung und Barcode-Scanning mit ML Kit können Nutzer den QR-Code an einem mobilen Geldkiosk einfach scannen und schnell Geld abheben. Die App ist für Nutzer in der Demokratischen Republik Kongo verfügbar und soll auch Mobilfunkanbieter in anderen afrikanischen Ländern unterstützen.

Texte von Arielle Bier

Illustration von Frances Haszard

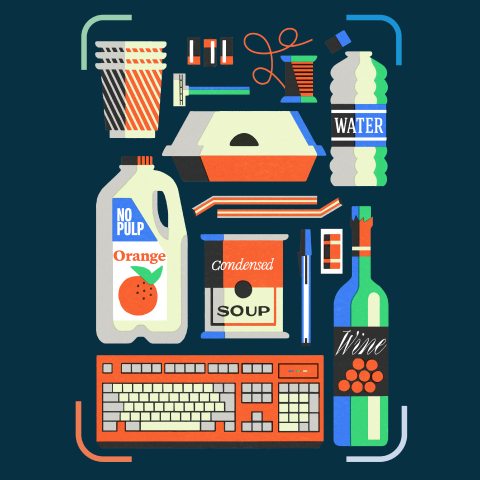

arrow_upwardMülltonne

Entwickler: Elvin Rakhmankulov, Arthur Dickerson, Gabor Daniel Vass, Yury Ulasenka

Standort: Chicago, USA

Der Klimawandel ist weltweit zu spüren. Die Menschen versuchen, ihre CO2-Bilanz zu verbessern und weniger Abfall auf Mülldeponien zu landen.

Während die meisten Städte Recyclingdienste anbieten, haben viele Orte unterschiedliche Regeln, Einschränkungen und Vorschriften. Aufgrund schlechter Kennzeichnung und widersprüchlicher Richtlinien füllen nicht recycelbare Objekte mehr als 25% der Recyclingbehälter.

Papierkorb erleichtert den Verbrauchern das Recycling. Richten Sie die Kamera des Geräts einfach auf einen Artikel. Über die Objekterkennung identifiziert und klassifiziert die App Plastikbecher, Taschen, Flaschen usw.. Anhand eines benutzerdefinierten TensorFlow Lite-Modells analysiert die App, ob das Objekt recycelbar ist und wie es – abhängig von den örtlichen Vorschriften – recycelt wird. Außerdem gibt sie Details zu Recyclingbehältern in der Nähe an.

Das Unternehmen ist in Illinois, Pennsylvania und Kalifornien aktiv. Es ermöglicht es, über die Funktion „In der Nähe“ 1.000 Recyclingzentren zu finden. Die Funktion soll in Zukunft auch in weiteren Bundesstaaten und Ländern eingeführt werden, um einen verantwortungsvollen Umgang mit Menschen zu fördern, die etwas bewirken können.

Texte von Arielle Bier

Illustration von Aless Mc

arrow_upwardUnodogs

Entwickler: Chinmay Mishra

Standort: Neu-Delhi, Indien

„Wir möchten ML nutzen, um jedem Hundebesitzer die Möglichkeit zu geben, die allgemeine Gesundheit seines Hundes genau einzuschätzen und daran zu arbeiten.“

Hunde sind für tägliche Bewegung, Futter und Pflege auf ihre Besitzer angewiesen. Trotz ihrer besten Absichten werden viele Hundebesitzer jedoch übergewichtig, wodurch sich ihre Lebenserwartung um bis zu 25 % verkürzt. UnoDogs unterstützt Besitzer mit individuellen Informationen und Fitnessprogrammen dabei, das Wohlbefinden ihres Haustiers zu verbessern. UnoDogs verfolgt und misst die Gesundheit eines Hundes und gibt angemessene Ratschläge, um Gesundheitsprobleme anzugehen, bevor sie beginnen.

UnoDogs verwendet die AutoML Vision-Funktion der Google Cloud Platform, um ein Objekterkennungsmodell zur Analyse von Live-Bildern zu trainieren. So kann UnoDogs den Körperzustandswert des Hundes berechnen und Empfehlungen für das ideale Gewicht und die ideale Größe geben. In zukünftigen Versionen werden weitere ML-gestützte Funktionen verfügbar sein, z. B. Essensempfehlungen, Agilitätstests und Fitnesspläne.

Die Details des Gewichts- und Trainingstrackings werden dann mit Echtzeitanalysen kombiniert, um leicht nachvollziehbare Ernährungs- und Trainingsprogramme zu erstellen, die darauf ausgelegt sind, den Eigentümer auf Kurs zu halten und inspiriert zu werden, damit sein Hund sein bestes Leben führen kann.

Texte von Arielle Bier

Illustration von Choi Haeryung

arrow_upwardAgrifarm

Entwickler: Mirwise Khan, Samina Ismail, Ehtisham Ahmed, Hassaan Khalid

Standort: Belutschisan, Pakistan

„Wir helfen Landwirten dabei, KI für ihre Produktivität zu nutzen.“

Pflanzenkrankheiten stellen für Bauern auf der ganzen Welt eine ständige Bedrohung dar. Die Auswirkungen der Ernährungsunsicherheit auf Gesundheit, Gesellschaft und Wirtschaft können verheerend sein. AgriFarm hilft Landwirten, Pflanzenkrankheiten zu erkennen und größere Schäden zu verhindern. Zu diesem Zweck wird der neuronale Deep-Learning-Netzwerkklassifikator, der zur Identifizierung der Krankheitsart verwendet wird, auf der Google Cloud AI Platform gehostet.

Weitere Features sind Wettervorhersagen, Videoempfehlungen und Preisvorhersagen. AgriFarm wurde für den Einsatz in entlegenen ländlichen Gebieten mit begrenztem Internetzugang entwickelt und deckt Obst und Gemüse wie Tomaten, Mais und Kartoffeln ab und erweitert den Datensatz, um weltweit zu funktionieren.

Texte von Arielle Bier

Illustration von Buba Viedma

arrow_upwardAgroDoc

Entwickler: Navneet Krishna

Standort: Kochi, Indien

„AgroDoc könnte solchen Menschen mit weniger Erfahrung in der Landwirtschaft wirklich helfen.“

AgroDoc basiert auf einem Crowdsourcing-Modell und hilft, Daten von Landwirten mit ähnlichen geografischen Standorten und Klimazonen zu erfassen, um Pflanzenkrankheiten zu diagnostizieren und Behandlungspläne zu erstellen. Mit der App wird ein infiziertes Blatt von einer Kamera auf dem Gerät gescannt und die TensorFlow Lite-Bibliothek hilft dabei, die Art der Krankheit zu erkennen.

Die Daten werden in Kombination mit den wichtigsten Symptomen analysiert und einfache Schritte zur Verbesserung der Pflanzengesundheit gegeben.

Texte von Arielle Bier

Illustration von Buba Viedma

arrow_upwardLogo: Stila

Entwickler: Yingding Wang

Standort: München, Deutschland

„In der modernen Gesellschaft ändern sich die Dinge so schnell und der Arbeitsdruck ist so groß, dass unser Körper auf diese Herausforderungen reagiert, als würde er von einem Tiger gejagt werden.“

Stress tritt in vielen Formen auf, sowohl positiv als auch negativ. Glücklicherweise sind unsere Körper darauf ausgelegt, sich selbst zu regulieren und sich an sich verändernde Umstände anzupassen. Wenn extreme Ereignisse oder Bedingungen jedoch ein hohes Stressniveau verursachen, können sich negative Auswirkungen bilden, die zu Angstzuständen, Depressionen und langfristigen Gesundheitsschäden führen. Stila (Stress-Tracking bei Lernaktivitäten) überwacht und verfolgt den körperlichen Stresspegel, damit Nutzer Stress besser verstehen und bewältigen können. Dazu arbeitet die Smartphone-App mit einem am Körper tragbaren Gerät wie dem Fitbit-Armband oder einem Gerät mit Wear OS by Google zusammen, das ihr Biofeedback aufzeichnet.

Ein benutzerdefiniertes Firebase-Modell erkennt und kategorisiert Stress, während der TensorFlow Lite-Interpreter die Offlineverarbeitung von Informationen ermöglicht. Die App erfasst das Stresslevel des Nutzers und wird mit kurzen Berichten über die Lebensereignisse und die Umgebung des Nutzers kombiniert. Anschließend wird ein Stresslevel berechnet, das hilft, den Stress bei bestimmten Aktivitäten einzuschätzen. Da jeder Mensch auf verschiedene Weise auf Stressfaktoren und Reize reagiert, lernt Stila aus diesen Berichten und passt seine Funktionsweise an. Es gibt dann Feedback, das auf den Rhythmus und die Bedürfnisse der einzelnen Nutzenden abgestimmt ist.

Einzelne Merkmale können verwendet werden, um die Nutzererfahrung durch Lerntransfer weiter zu personalisieren. Durch die Erkennung und Überwachung des Stresslevels im Zeitverlauf können Nutzer Stress besser bewältigen.

Texte von Arielle Bier

Illustration von Linn Fritz

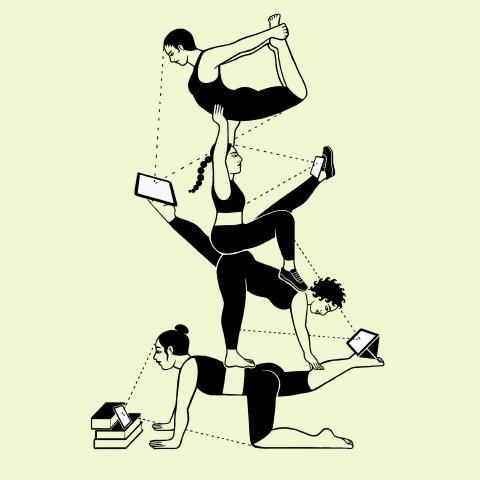

arrow_upwardMixpose

Entwickler: Peter Ma, Sarah Han

Standort: San Francisco, USA

„Wir alle machen regelmäßig Yoga und wir alle sind Softwareentwickler. Wir wollten herausfinden, wie Technologien dazu beitragen können, Yoga und Fitness noch besser zu machen.“

MixPose ist eine Livestreaming-Plattform, die Yogalehrern und Fitnessexperten die Möglichkeit gibt, zu unterrichten, die Ausrichtung zu verfolgen und Feedback in Echtzeit zu geben. Statische Fitnessvideos tauschen Informationen nur in eine Richtung aus. Aber mit dieser App können Lehrkräfte ihren Unterricht anpassen und direkt auf die Bedürfnisse der Lernenden eingehen. Das Posen-Tracking erkennt die Bewegungen der einzelnen Nutzer und die Positionen werden mit dem ML Kit und PoseNet klassifiziert.

Anschließend informieren Live-Sensoren und Feedbacksysteme sie über ihre Ausrichtung. Zusätzliche Ausgabe für Videofunktionen wie Chromecast, die für ein noch immersiveres Betrachten mit größeren Bildschirmen verbunden werden können. MixPose wurde für die 37 Millionen US-Amerikaner entwickelt, die Yoga ausüben, und hat für die Einführung mehr als 100 Yogalehrer ins Boot geholt. Durch Innovationen mit KI auf Edge-Geräten, 5G und Smart-TV bietet diese Plattform Nutzern interaktive Kurse zu Hause.

Texte von Arielle Bier

Illustration von Rachel Levit Ruiz

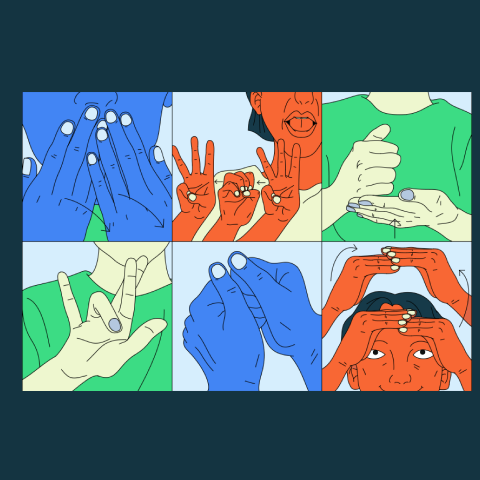

arrow_upwardLeepi

Entwickler: Prince Patel, Aman Arora, Aditya Narayan

Standort: Bengaluru, Indien

„Etwa 7 Millionen Menschen in Indien haben Beeinträchtigungen beim Hören und Sprechen.“

Über sieben Millionen Menschen in Indien haben Beeinträchtigungen beim Hören und Sprechen, aber nur wenige haben Zugang zu Gebärdensprache. Da die Vielfalt der Sprachen und Dialekte so vielfältig ist, ist es nahezu unmöglich, eine Standardform der Kommunikation zu schaffen.

Mit Leepi können Schüler Handgesten und Symbole für amerikanische Gebärdensprache erlernen. Die App nutzt Buchstaben-, Symbol-, Gesichts- und Absichtserkennung sowie interaktive Übungen und Echtzeit-Feedback. Die TensorFlow Lite-Bibliothek und das MediaPipe-Framework wurden verwendet, um die On-Device-Verarbeitung genauer und zu optimieren. Außerdem wurde sie für die Offlinenutzung entwickelt, damit mehr Schüler und Studenten barrierefrei lernen können.

Texte von Arielle Bier

Illustration von Xuetong Wang

arrow_upwardSchnarchen und Husten

Entwickler: Ethan Fan

Standort: Mountain View, CA, USA

„Unsere Lösung ist die Audioklassifizierung durch Deep Learning.“

Guter Schlaf ist wichtig für die Erholung und die Regeneration des menschlichen Körpers. Dennoch schnarchen 25% der Erwachsenen regelmäßig, was zu Schlafunterbrechungen und potenziell chronischen Gesundheitsproblemen führen kann.

Durch das Aufnehmen, Analysieren und Klassifizieren von Audiodaten mit TensorFlow Lite erkennt die App „Schnarchen und Husten“ Schnarch- und Hustengeräusche und hilft Nutzern so, Hilfe von einem Arzt zu erhalten.

Texte von Arielle Bier

Illustration von Xuetong Wang

arrow_upwardPfadfinder

Entwickler: Colin Shelton, Jing Chang, Sam Grogan, Eric Emery

Standort: Addison, Texas, USA

„Wir wollten maschinelles Lernen nutzen, um ein Gemeinwohl zu erreichen.“

Wenn Sie öffentliche Umgebungen durchqueren, z. B. ein Einkaufszentrum oder eine überfüllte Straße, verschieben sich ständig bewegende Hindernisse und verändern sich auf unerwartete Weise. Sensorische Erlebnisse wie Sehen, Geräusch und Berührung können dazu beitragen, Kollisionen und Unfälle zu vermeiden. Sehbehinderte müssen beim Navigieren durch öffentliche Umgebungen mit einer Reihe von Unbekannten konfrontiert werden. Path Finder kann Menschen mit Sehbehinderung dabei helfen, solch komplexe Situationen zu meistern. Dazu werden die Flugbahnen von Objekten, die sich auf ihrem Weg bewegen, ermittelt und berechnet.

Benutzerdefinierte Benachrichtigungen informieren den Nutzer dann darüber, wie er diese Hindernisse umgehen kann, und schlagen Maßnahmen vor, die er auf sichere Weise ergreifen kann. Diese App verwendet die Objekterkennung von TensorFlow Lite, um die Entfernungen von umgebenden Objekten zu berechnen. Sie wurde entwickelt, um den Nutzer zu unterstützen, Informationen zu teilen und Unterstützung zu bieten, anstatt ihn in schwierigen Situationen zu überfordern. Daher ist der Einrichtungsprozess von Path Finder auf dialogorientiert und auf Nutzer mit eingeschränktem Sehvermögen sowie auf Personen zugeschnitten, die ihnen helfen.

Sowohl akustisches als auch haptisches Feedback sind Teil des Hinderniswarnsystems, während eine Reihe von Neigungen und Frequenzen die Entfernung und Richtung jedes Objekts angeben. Audiomuster wie Morsecode werden dann übereinandergelegt und kombiniert, um weitere Informationen bereitzustellen. Mit dem Pfadfinder können sehbehinderte Nutzer durch die Voraussicht in öffentlichen Umgebungen navigieren.

Texte von Arielle Bier

Illustration von Sonya Korshenboym

arrow_upward