대규모 언어 모델 (LLM)은 기능이 서로 다릅니다. AI 지원 소프트웨어 개발을 제어하고 유연하게 사용할 수 있도록 Android 스튜디오에서는 개인 머신에서 실행되는 로컬 모델을 선택하여 IDE의 AI 기능을 지원할 수 있습니다.

모델 선택

로컬 모델은 Android 스튜디오에 내장된 LLM 지원의 대안을 제공하지만, Android 스튜디오의 Gemini는 강력한 Gemini 모델 덕분에 일반적으로 Android 개발자에게 최고의 AI 환경을 제공합니다. 무료 기본 모델 또는 유료 Gemini API 키로 액세스하는 모델 등 다양한 Gemini 모델 중에서 Android 개발 작업에 사용할 모델을 선택할 수 있습니다.

오프라인으로 작업해야 하거나, AI 도구 사용에 관한 엄격한 회사 정책을 준수해야 하거나, 오픈소스 연구 모델을 실험해 보고 싶은 경우 로컬 모델 기능을 사용하는 것이 좋습니다.

로컬 모델 지원 설정

최신 Canary 버전의 Android 스튜디오를 다운로드하고 설치합니다.

Android 스튜디오에 모델 제공자를 추가합니다.

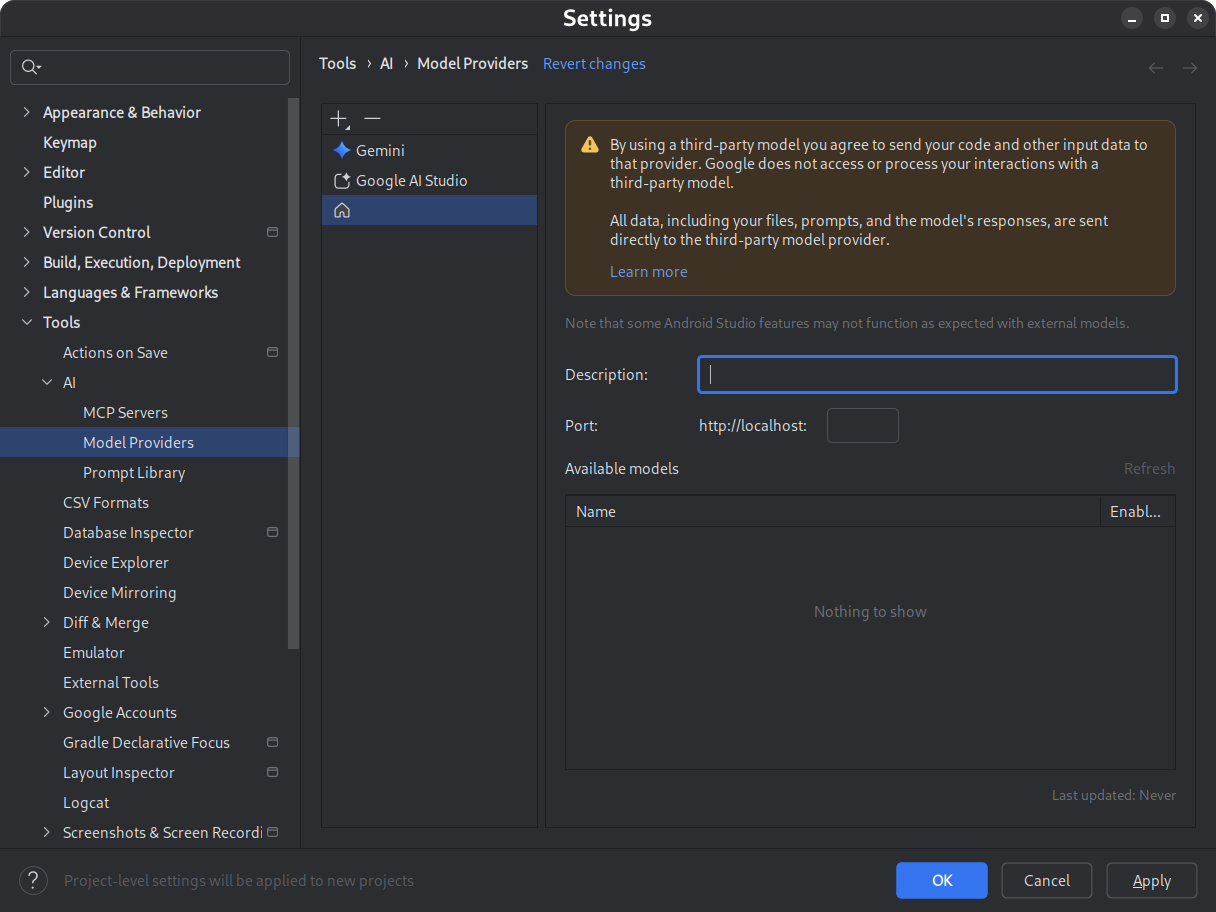

- 설정 > 도구 > AI > 모델 제공업체로 이동합니다.

- 아이콘을 선택합니다.

- 지역 제공업체를 선택합니다.

- 모델 제공업체 (일반적으로 모델 제공업체의 이름)의 설명을 입력합니다.

- 제공자가 수신 대기하는 포트 설정

- 모델 사용 설정

그림 1. 모델 제공업체 설정입니다. 원하는 모델을 다운로드하여 설치합니다.

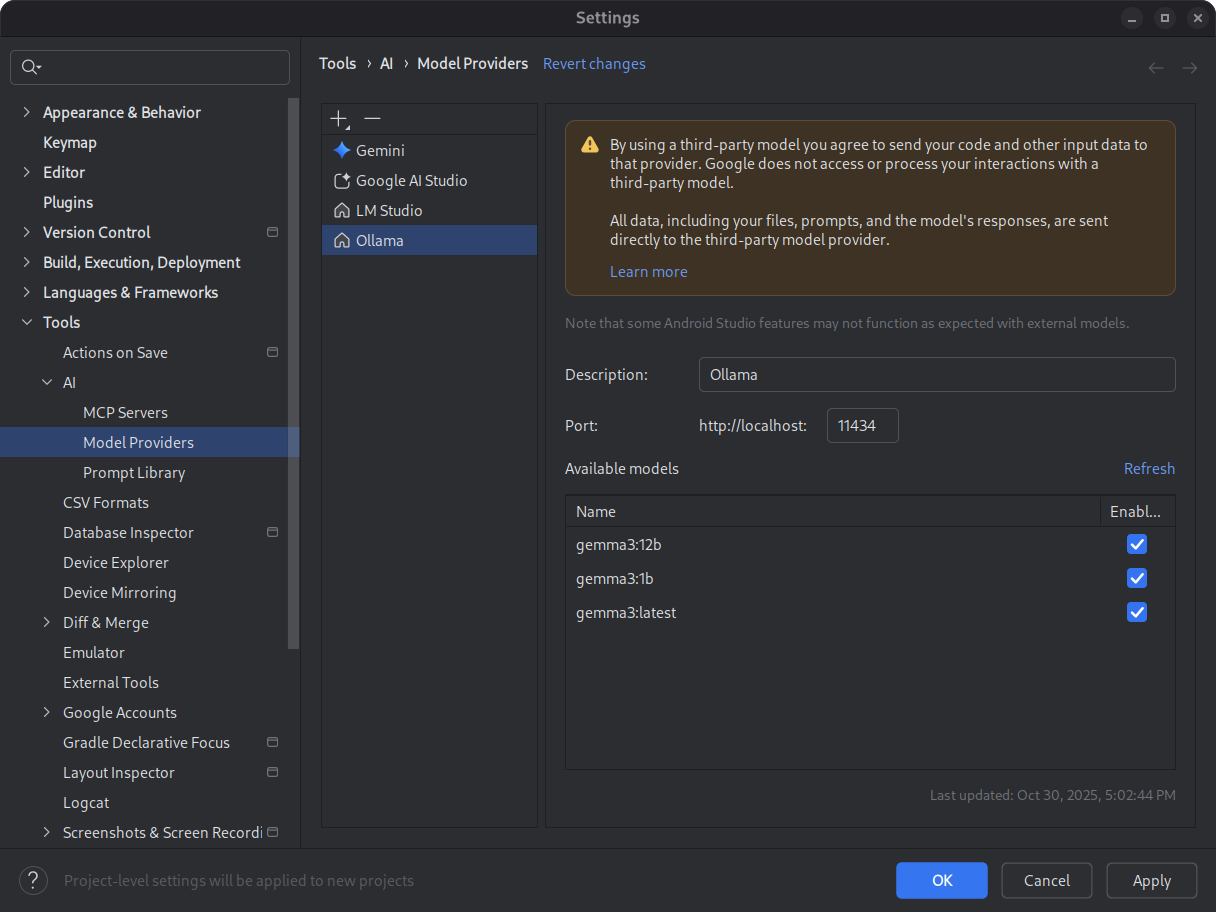

LM Studio 및 Ollama 모델 카탈로그를 참고하세요. Android 스튜디오의 에이전트 모드를 최적의 환경에서 사용하려면 도구 사용을 위해 학습된 모델을 선택하세요.

그림 2. 사용 가능한 로컬 모델입니다. 추론 환경을 시작합니다.

추론 환경은 로컬 애플리케이션에 모델을 제공합니다. 최적의 성능을 위해 충분히 큰 컨텍스트 길이 토큰 창을 구성합니다. 환경을 시작하고 구성하는 방법에 관한 자세한 내용은 Ollama 또는 LM Studio 문서를 참고하세요.

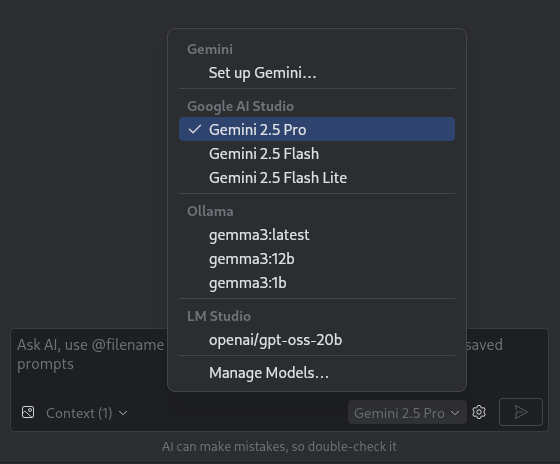

모델을 선택합니다.

Android 스튜디오를 엽니다. Gemini 채팅 창으로 이동합니다. 모델 선택기를 사용하여 기본 Gemini 모델에서 구성된 로컬 모델로 전환합니다.

그림 3. 모델 선택 도구

Android 스튜디오를 로컬 모델에 연결한 후 IDE 내에서 채팅 기능을 사용할 수 있습니다. 모든 상호작용은 로컬 머신에서 실행되는 모델에 의해 완전히 지원되므로 자체 포함 AI 개발 환경을 제공합니다.

성능 제한사항 고려

로컬 오프라인 모델은 일반적으로 클라우드 기반 Gemini 모델만큼 성능이 좋거나 지능적이지 않습니다. 로컬 모델의 채팅 응답은 일반적으로 클라우드 기반 모델에 비해 정확도가 낮고 지연 시간이 깁니다.

로컬 모델은 일반적으로 Android 개발을 위해 미세 조정되지 않으며 로컬 모델은 Android 스튜디오 사용자 인터페이스에 대해 알지 못하는 응답을 반환할 수 있습니다. 일부 Android 스튜디오 AI 기능과 Android 개발 사용 사례는 로컬 모델에서 작동하지 않습니다. 하지만 Android 스튜디오의 AI 채팅 기능은 일반적으로 로컬 모델에서 지원됩니다.

Android 개발의 모든 측면에 대한 빠르고 정확한 대답과 모든 Android 스튜디오 기능 지원을 위해 Gemini 모델로 구동되는 Android 스튜디오의 Gemini가 최적의 솔루션입니다.