Большие языковые модели (LLM) различаются по своим возможностям. Чтобы обеспечить вам контроль и гибкость в разработке программного обеспечения с использованием ИИ, Android Studio позволяет выбрать локальную модель, работающую на вашем персональном компьютере, для обеспечения работы функций ИИ в IDE.

Выберите модель

Локальная модель предлагает альтернативу встроенной в Android Studio поддержке LLM; однако Gemini в Android Studio обычно обеспечивает наилучший опыт работы с ИИ для разработчиков Android благодаря мощным моделям Gemini . Вы можете выбрать одну из множества моделей Gemini для своих задач разработки Android, включая бесплатную модель по умолчанию или модели, доступ к которым осуществляется с помощью платного ключа API Gemini .

Возможность локальной работы с моделями — отличный вариант, если вам нужно работать в автономном режиме, соблюдать строгие корпоративные правила использования инструментов ИИ или вы заинтересованы в экспериментах с исследовательскими моделями с открытым исходным кодом.

Настройка поддержки локальной модели

Загрузите и установите последнюю тестовую версию Android Studio (canary) .

Установите на свой локальный компьютер программу для работы с LLM-программами, например LM Studio или Ollama .

Добавьте поставщика моделей в Android Studio.

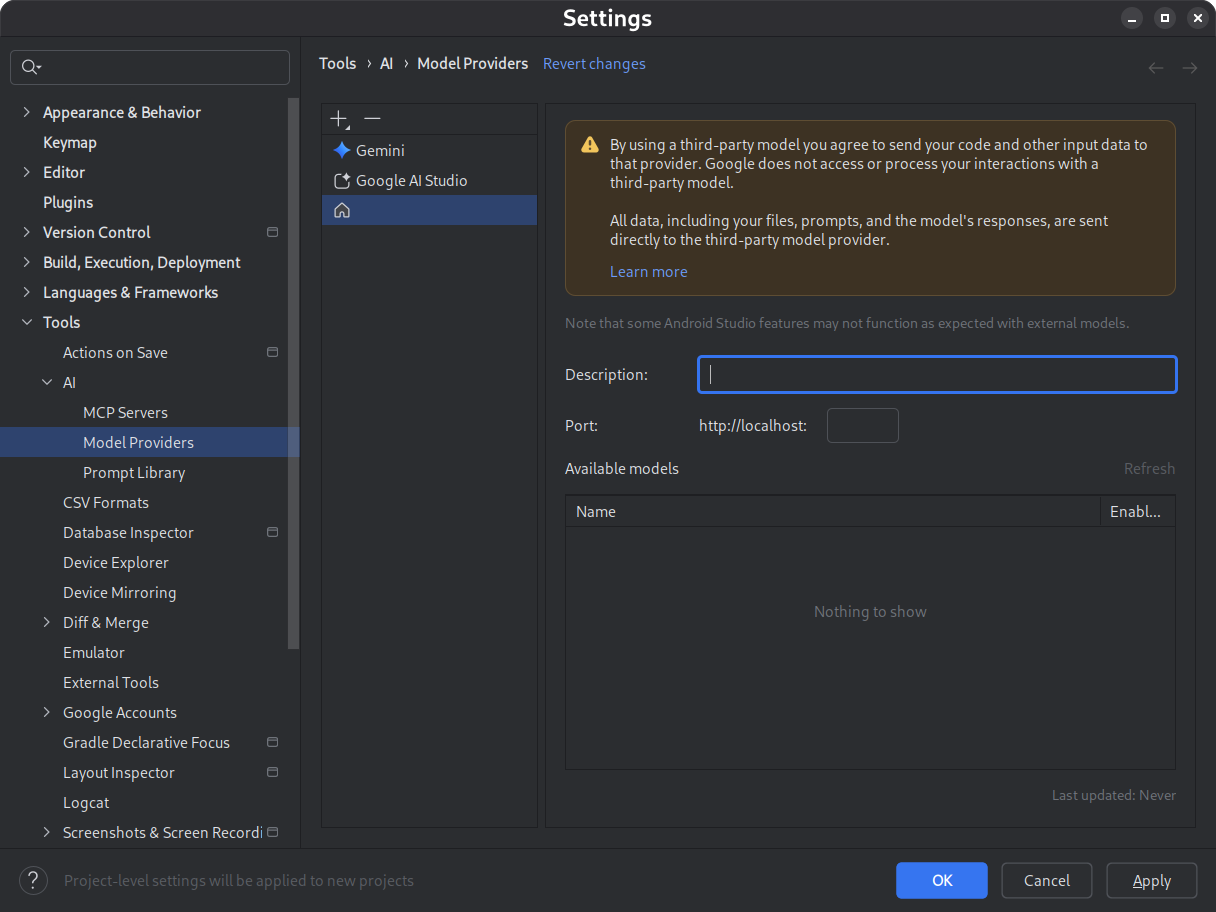

- Перейдите в Настройки > Инструменты > ИИ > Поставщики моделей

- Select the icon

- Выберите местного поставщика

- Введите описание поставщика модели (обычно это название поставщика модели).

- Укажите порт, на котором провайдер принимает запросы.

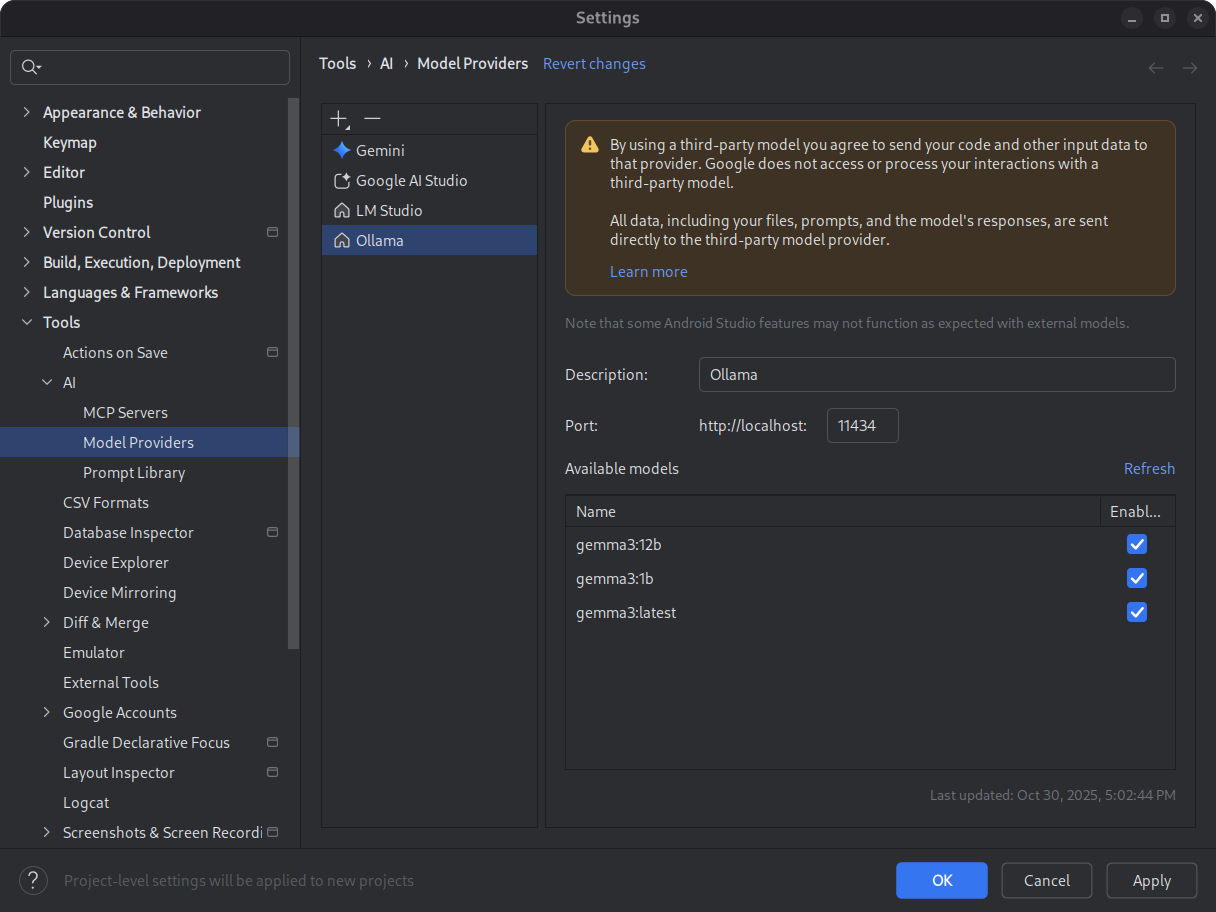

- Включить модель

Рисунок 1. Настройки поставщика модели. Скачайте и установите выбранную вами модель.

См. каталоги моделей LM Studio и Ollama . Для наилучшего использования режима агента в Android Studio выберите модель, обученную для работы с инструментами.

Рисунок 2. Доступные локальные модели. Запустите среду вывода.

Среда вывода предоставляет вашу модель локальным приложениям. Для оптимальной производительности настройте достаточно большое окно длины контекстного токена. Подробные инструкции по запуску и настройке среды см. в документации Ollama или LM Studio .

Выберите модель.

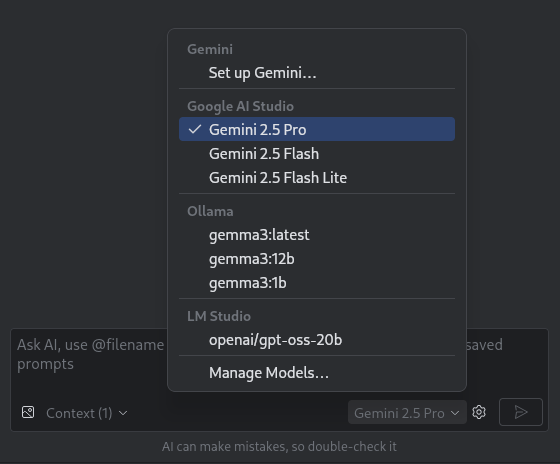

Откройте Android Studio. Перейдите в окно чата Gemini. Используйте средство выбора модели, чтобы переключиться со стандартной модели Gemini на вашу локальную модель, настроенную вами.

Рисунок 3. Инструмент выбора модели.

После подключения Android Studio к локальной модели вы можете использовать функции чата в IDE. Все взаимодействия полностью обеспечиваются моделью, работающей на вашем локальном компьютере, что предоставляет вам автономную среду разработки ИИ.

Учитывайте ограничения производительности.

Локальные, работающие в автономном режиме модели, как правило, уступают по производительности и интеллекту облачным моделям Gemini. Ответы в чате от локальных моделей обычно менее точны и имеют большую задержку по сравнению с облачными моделями.

Локальные модели обычно не оптимизированы для разработки под Android, и могут возвращать ответы, не учитывающие пользовательский интерфейс Android Studio. Некоторые функции ИИ в Android Studio и сценарии использования в разработке под Android не работают с локальной моделью. Однако функция чата с использованием ИИ в Android Studio, как правило, поддерживается локальными моделями.

Для быстрых и точных ответов по всем аспектам разработки Android-приложений и поддержки всех функций Android Studio, Gemini в Android Studio , работающий на основе моделей Gemini , — это ваше лучшее решение.