Duże modele językowe (LLM) różnią się możliwościami. Aby zapewnić Ci kontrolę i elastyczność w zakresie tworzenia oprogramowania z pomocą AI, Android Studio umożliwia wybór lokalnego modelu działającego na Twoim komputerze osobistym, który będzie obsługiwać funkcje AI w IDE.

Wybierz model

Model lokalny jest alternatywą dla obsługi LLM wbudowanej w Android Studio. Jednak Gemini w Android Studio zwykle zapewnia najlepsze wrażenia związane z AI dla programistów Androida ze względu na zaawansowane modele Gemini. Do zadań związanych z tworzeniem aplikacji na Androida możesz wybrać różne modele Gemini, w tym bezpłatny model domyślny lub modele, do których dostęp uzyskasz za pomocą płatnego klucza Gemini API.

Możliwość korzystania z modelu lokalnego to świetna opcja, jeśli musisz pracować w trybie offline, przestrzegać ścisłych zasad firmy dotyczących korzystania z narzędzi AI lub chcesz eksperymentować z modelami badawczymi typu open source.

Konfigurowanie obsługi modelu lokalnego

Pobierz i zainstaluj najnowszą wersję Canary Android Studio.

Zainstaluj na komputerze lokalnym dostawcę LLM, np. LM Studio lub Ollama.

Dodaj dostawcę modelu do Android Studio.

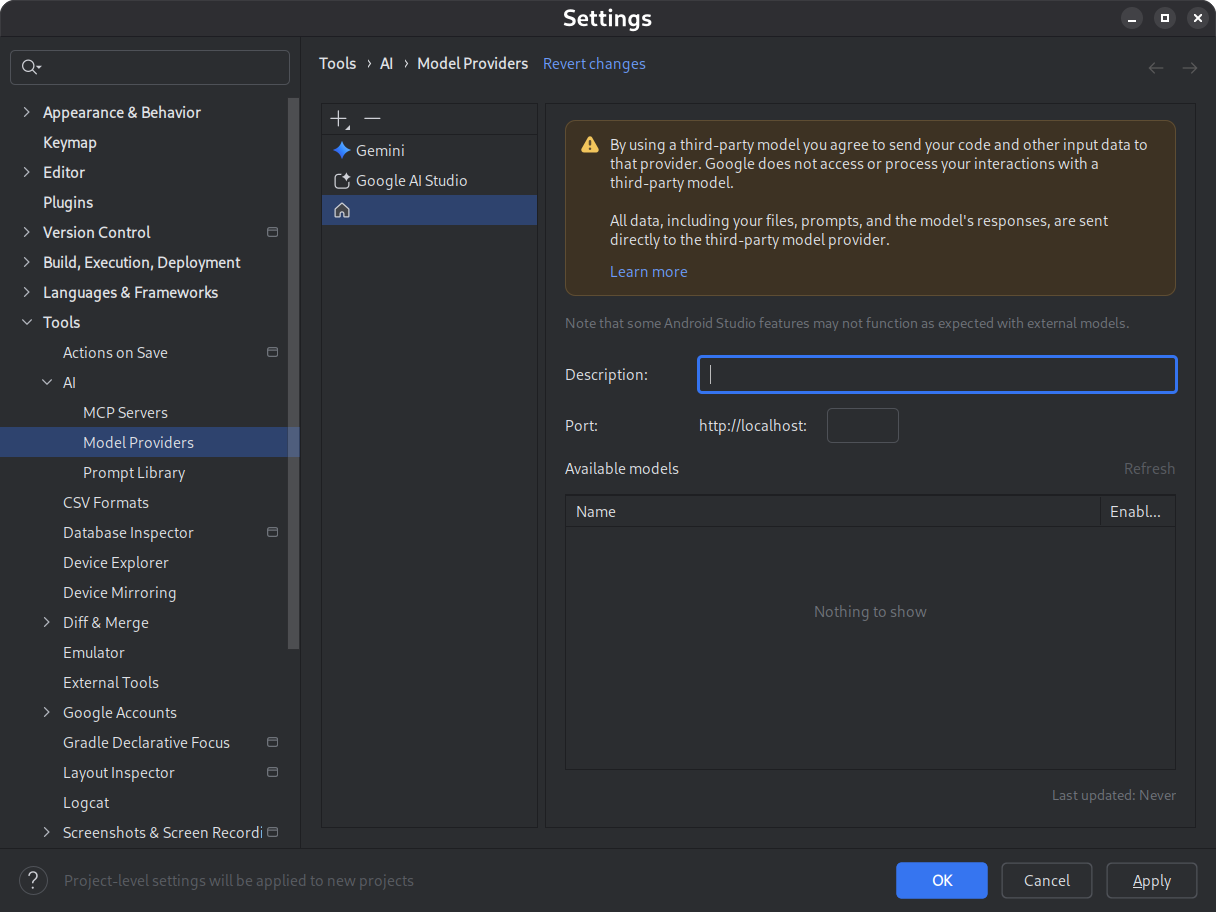

- Otwórz Ustawienia > Narzędzia > AI > Dostawcy modeli.

- Kliknij ikonę .

- Wybierz Lokalny dostawca.

- Wpisz opis dostawcy modelu (zwykle nazwę dostawcy modelu).

- Ustaw port, na którym nasłuchuje dostawca

- Włączanie modelu

Rysunek 1. Ustawienia dostawcy modelu. Pobierz i zainstaluj wybrany model.

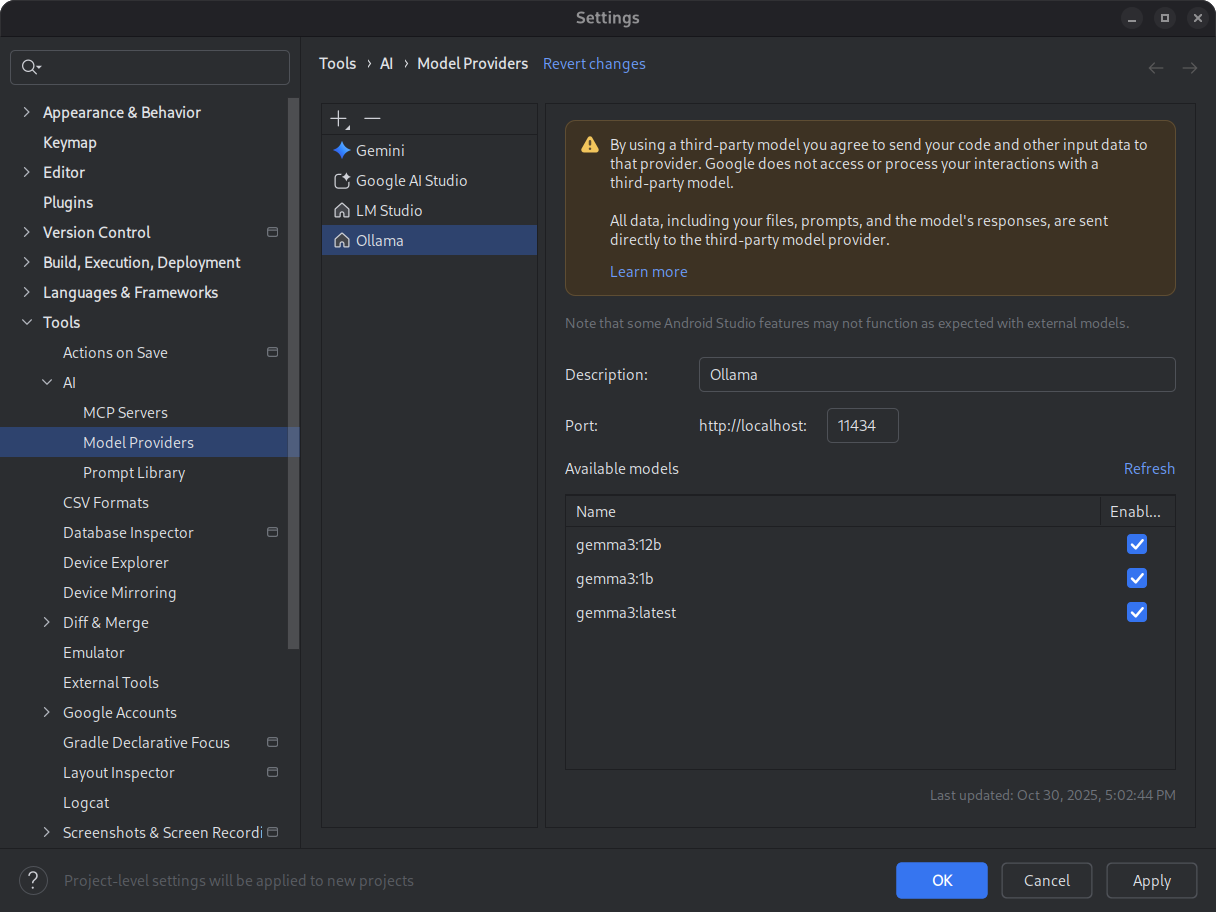

Zapoznaj się z katalogami modeli LM Studio i Ollama. Aby w pełni korzystać z trybu agenta w Android Studio, wybierz model wytrenowany pod kątem używania narzędzi.

Rysunek 2. Dostępne modele lokalne. Uruchom środowisko wnioskowania.

Środowisko wnioskowania udostępnia model aplikacjom lokalnym. Skonfiguruj wystarczająco duże okno tokenów o długości kontekstu, aby uzyskać optymalną wydajność. Szczegółowe instrukcje dotyczące uruchamiania i konfigurowania środowiska znajdziesz w dokumentacji Ollamy lub LM Studio.

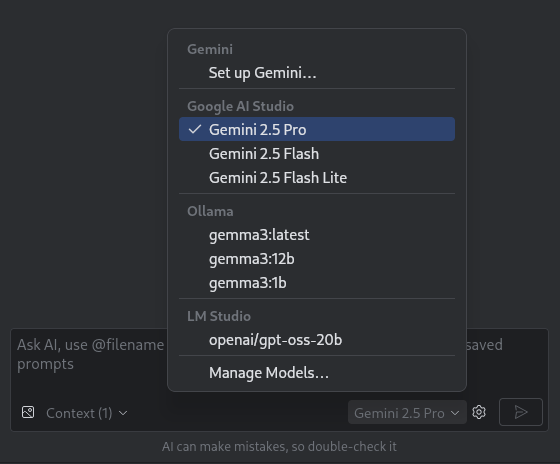

Wybierz model.

Otwórz Android Studio. Przejdź do okna czatu z Gemini. Użyj selektora modeli, aby przełączyć się z domyślnego modelu Gemini na skonfigurowany model lokalny.

Rysunek 3. menu modeli

Po połączeniu Android Studio z modelem lokalnym możesz korzystać z funkcji czatu w IDE. Wszystkie interakcje są w pełni obsługiwane przez model działający na komputerze lokalnym, co zapewnia samodzielne środowisko programistyczne AI.

Ograniczenia wydajności

Lokalny model offline zwykle nie jest tak wydajny ani inteligentny jak modele Gemini oparte na chmurze. Odpowiedzi na czacie z modeli lokalnych są zwykle mniej dokładne i mają większe opóźnienie w porównaniu z modelami opartymi na chmurze.

Modele lokalne zwykle nie są dostrajane pod kątem programowania na Androida i mogą zwracać odpowiedzi, które nie uwzględniają interfejsu użytkownika Androida Studio. Niektóre funkcje AI w Android Studio i przypadki użycia związane z programowaniem na Androida nie działają z modelem lokalnym. Funkcja czatu AI w Android Studio jest jednak zwykle obsługiwana przez modele lokalne.

Aby szybko i dokładnie uzyskiwać odpowiedzi na pytania dotyczące wszystkich aspektów tworzenia aplikacji na Androida i korzystać ze wszystkich funkcji Android Studio, używaj Gemini w Android Studio, czyli narzędzia opartego na modelach Gemini.