大規模言語モデル(LLM)は、機能が異なります。AI を活用したソフトウェア開発を制御し、柔軟に対応できるように、Android Studio では、IDE の AI 機能を強化するために、個人のマシンで実行されるローカルモデルを選択できます。

モデルを選択する

ローカルモデルは、Android Studio に組み込まれている LLM サポートの代替手段となりますが、通常、Gemini モデルの強力な機能により、Gemini in Android Studio が Android デベロッパーに最高の AI エクスペリエンスを提供します。Android 開発タスクでは、さまざまな Gemini モデルを選択できます。たとえば、無料のデフォルト モデルや、有料の Gemini API キーでアクセスするモデルなどがあります。

ローカルモデル機能は、オフラインで作業する必要がある場合、AI ツールの使用に関する厳格な企業ポリシーを遵守する必要がある場合、オープンソースの研究モデルを試してみたい場合に最適なオプションです。

ローカルモデルのサポートを設定する

Android Studio の最新のカナリア版をダウンロードしてインストールします。

モデル プロバイダを Android Studio に追加します。

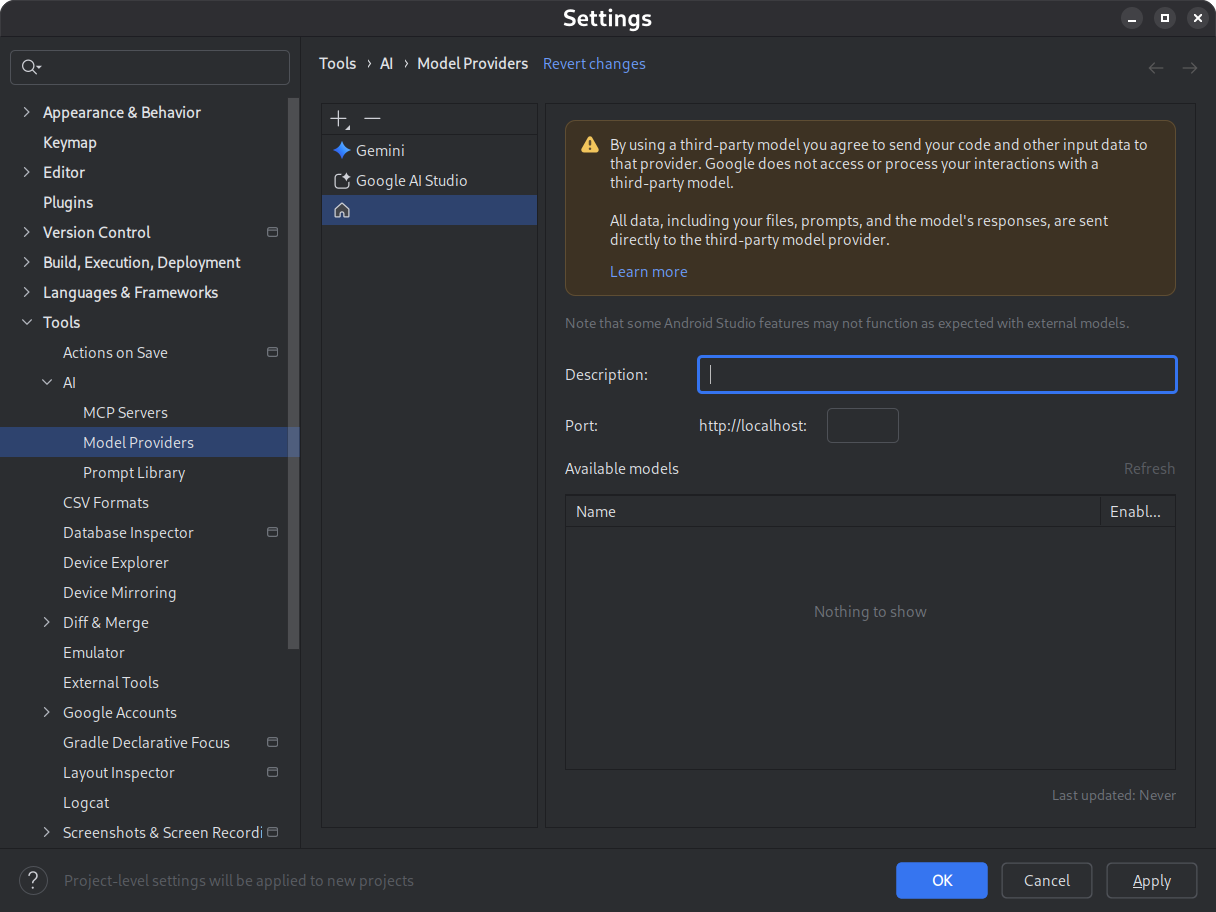

- [設定] > [ツール] > [AI] > [モデル プロバイダ] に移動します。

- アイコンを選択します。

- [Local Provider] を選択します。

- モデル プロバイダの説明(通常はモデル プロバイダの名前)を入力します。

- プロバイダがリッスンしているポートを設定する

- モデルを有効にする

図 1. モデル プロバイダの設定。 選択したモデルをダウンロードしてインストールします。

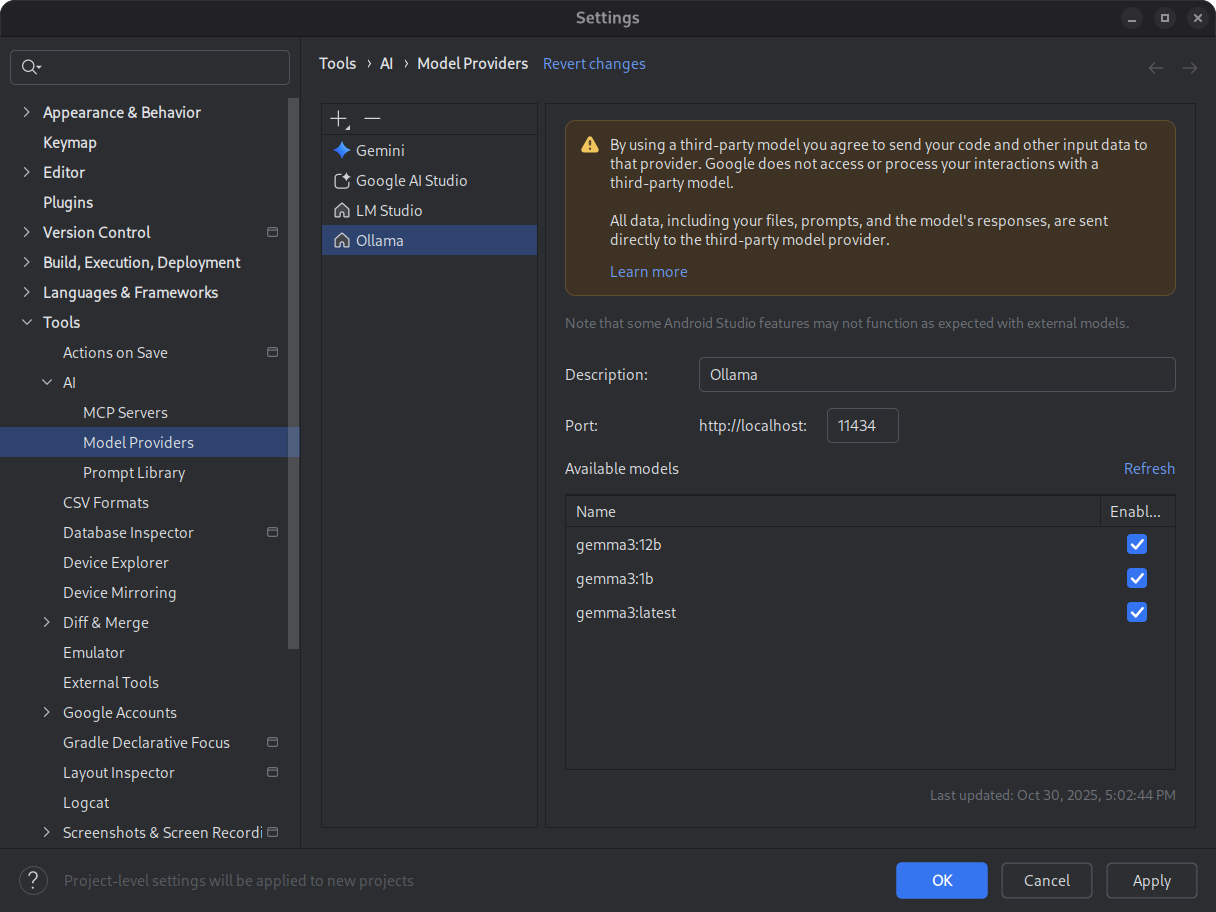

LM Studio と Ollama のモデル カタログをご覧ください。Android Studio のエージェント モードを最大限に活用するには、ツール使用向けにトレーニングされたモデルを選択します。

図 2. 使用可能なローカルモデル。 推論環境を開始します。

推論環境は、ローカル アプリケーションにモデルを提供します。最適なパフォーマンスを実現するために、十分な大きさのコンテキスト長トークン ウィンドウを構成します。環境の起動と構成の詳細な手順については、Ollama または LM Studio のドキュメントをご覧ください。

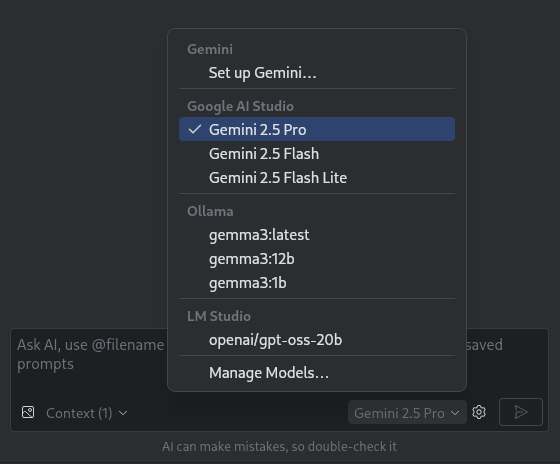

モデルを選択します。

Android Studio を開きます。Gemini チャット ウィンドウに移動します。モデル選択ツールを使用して、デフォルトの Gemini モデルから構成済みのローカルモデルに切り替えます。

図 3. モデル選択ツール。

Android Studio をローカルモデルに接続すると、IDE 内でチャット機能を使用できるようになります。すべてのインタラクションはローカルマシンで実行されるモデルによって完全に処理されるため、自己完結型の AI 開発環境が実現します。

パフォーマンスの制限事項を考慮する

通常、ローカルのオフライン モデルは、クラウドベースの Gemini モデルほどパフォーマンスやインテリジェンスが高くありません。ローカルモデルからのチャット レスポンスは、通常、クラウドベースのモデルよりも精度が低く、レイテンシが高くなります。

ローカルモデルは通常、Android 開発用にファインチューニングされていません。そのため、ローカルモデルは Android Studio ユーザー インターフェースに関する情報のないレスポンスを返すことがあります。Android Studio の一部の AI 機能と Android 開発のユースケースは、ローカルモデルでは機能しません。ただし、Android Studio の AI チャット機能は通常、ローカルモデルでサポートされています。

Android 開発のあらゆる側面に関する迅速かつ正確な回答と、Android Studio のすべての機能のサポートには、Gemini モデルを搭載した Gemini in Android Studio が最適です。