مدلهای زبان بزرگ (LLM) از نظر قابلیتهایشان متفاوت هستند. برای اینکه در توسعه نرمافزار با کمک هوش مصنوعی کنترل و انعطافپذیری بیشتری داشته باشید، اندروید استودیو به شما امکان میدهد یک مدل محلی را که روی دستگاه شخصی شما اجرا میشود، برای تقویت عملکرد هوش مصنوعی IDE انتخاب کنید.

یک مدل انتخاب کنید

یک مدل محلی جایگزینی برای پشتیبانی LLM تعبیهشده در اندروید استودیو ارائه میدهد؛ با این حال، Gemini در اندروید استودیو معمولاً به دلیل مدلهای قدرتمند Gemini، بهترین تجربه هوش مصنوعی را برای توسعهدهندگان اندروید فراهم میکند. شما میتوانید از بین مدلهای Gemini متنوع برای وظایف توسعه اندروید خود، از جمله مدل پیشفرض بدون هزینه یا مدلهایی که با کلید API Gemini پولی قابل دسترسی هستند، انتخاب کنید.

اگر نیاز به کار آفلاین دارید، باید به سیاستهای سختگیرانه شرکت در مورد استفاده از ابزار هوش مصنوعی پایبند باشید، یا علاقهمند به آزمایش مدلهای تحقیقاتی متنباز هستید، قابلیت مدل محلی گزینه بسیار خوبی است.

پشتیبانی مدل محلی را راهاندازی کنید

آخرین نسخه Canary اندروید استودیو را دانلود و نصب کنید.

یک ارائه دهنده خدمات LLM مانند LM Studio یا Ollama را روی رایانه محلی خود نصب کنید.

ارائه دهنده مدل را به اندروید استودیو اضافه کنید.

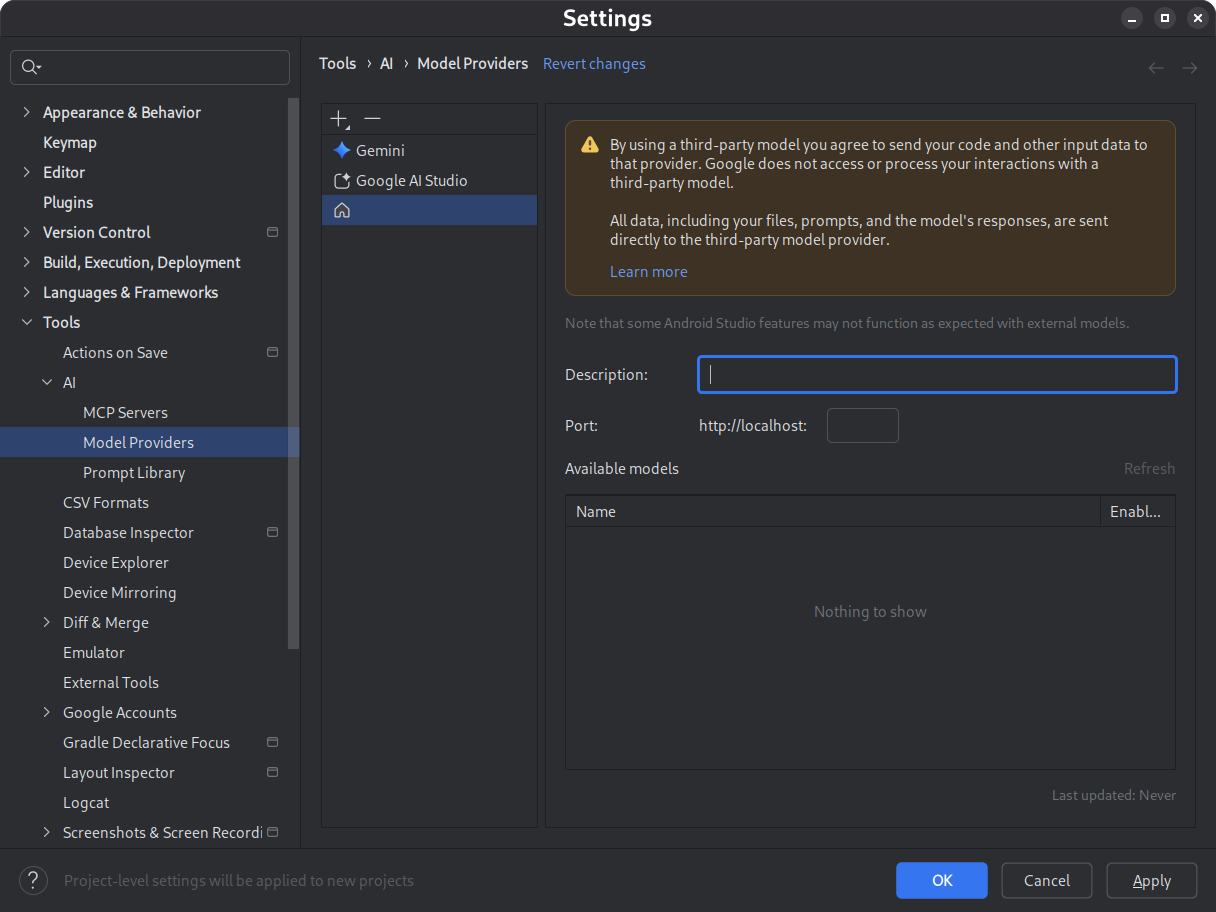

- به تنظیمات > ابزارها > هوش مصنوعی > ارائه دهندگان مدل بروید

- آیکون را انتخاب کنید

- ارائه دهنده محلی را انتخاب کنید

- توضیحی از ارائهدهنده مدل وارد کنید (معمولاً نام ارائهدهنده مدل)

- پورتی را که ارائه دهنده به آن گوش میدهد تنظیم کنید

- فعال کردن یک مدل

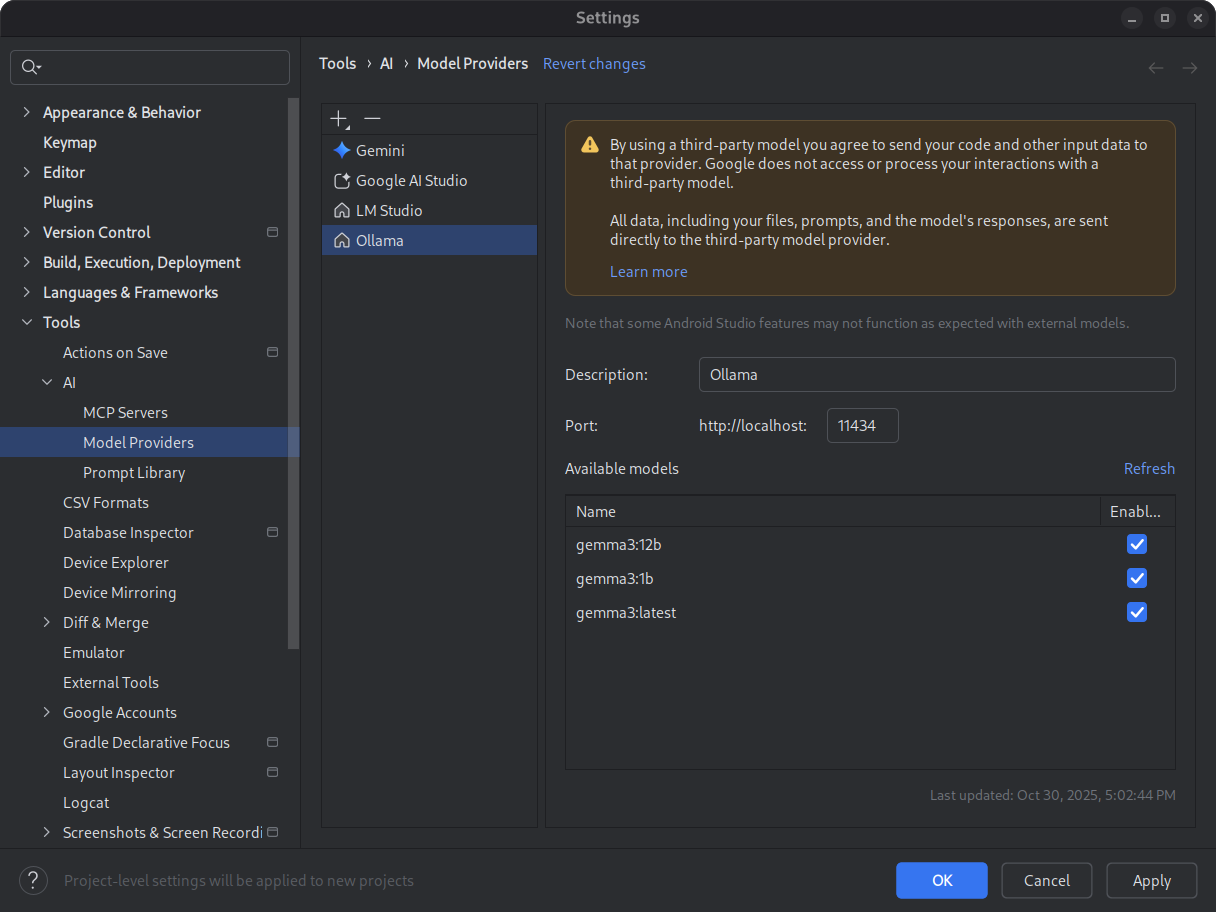

شکل ۱. تنظیمات ارائهدهنده مدل. مدل مورد نظر خود را دانلود و نصب کنید.

به کاتالوگهای مدل LM Studio و Ollama مراجعه کنید. برای بهترین تجربه با حالت عامل در اندروید استودیو، مدلی را انتخاب کنید که برای استفاده از ابزار آموزش دیده باشد.

شکل ۲. مدلهای محلی موجود. محیط استنتاج خود را شروع کنید.

محیط استنتاج، مدل شما را در اختیار برنامههای محلی قرار میدهد. برای عملکرد بهینه، یک پنجره توکن با طول زمینه به اندازه کافی بزرگ پیکربندی کنید. برای دستورالعملهای دقیق در مورد شروع و پیکربندی محیط خود، به مستندات Ollama یا LM Studio مراجعه کنید.

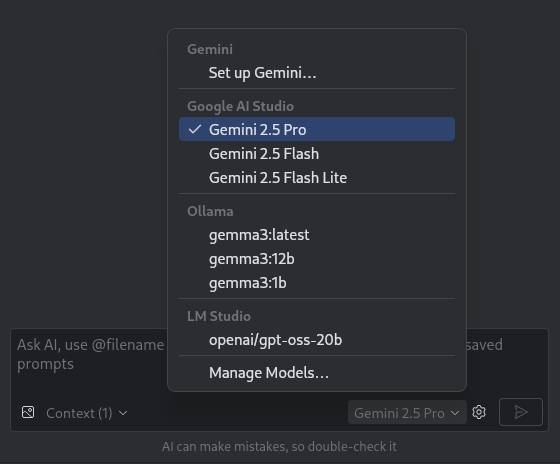

یک مدل انتخاب کنید.

اندروید استودیو را باز کنید. به پنجره چت Gemini بروید. از انتخابگر مدل برای تغییر از مدل پیشفرض Gemini به مدل محلی پیکربندی شده خود استفاده کنید.

شکل ۳. انتخابگر مدل.

بعد از اینکه اندروید استودیو را به مدل محلی خود متصل کردید، میتوانید از ویژگیهای چت درون IDE استفاده کنید. تمام تعاملات کاملاً توسط مدلی که روی دستگاه محلی شما اجرا میشود، پشتیبانی میشوند و یک محیط توسعه هوش مصنوعی مستقل را در اختیار شما قرار میدهند.

محدودیتهای عملکرد را در نظر بگیرید

یک مدل محلی و آفلاین معمولاً به اندازه مدلهای مبتنی بر ابر Gemini کارآمد یا هوشمند نخواهد بود. پاسخهای چت از مدلهای محلی معمولاً دقت کمتری دارند و در مقایسه با مدلهای مبتنی بر ابر، تأخیر بیشتری دارند.

مدلهای محلی معمولاً برای توسعه اندروید به خوبی تنظیم نشدهاند و میتوانند پاسخهایی را برگردانند که از رابط کاربری اندروید استودیو بیاطلاع هستند. برخی از ویژگیهای هوش مصنوعی اندروید استودیو و موارد استفاده توسعه اندروید با یک مدل محلی غیرعملیاتی هستند. با این حال، ویژگی چت هوش مصنوعی در اندروید استودیو عموماً توسط مدلهای محلی پشتیبانی میشود.

برای پاسخهای سریع و دقیق در تمام جنبههای توسعه اندروید و پشتیبانی از تمام ویژگیهای اندروید استودیو، Gemini در اندروید استودیو ، که توسط مدلهای Gemini پشتیبانی میشود، بهترین راهحل شماست.