Vincitori della sfida per gli sviluppatori Android

Eskke

Sviluppatore: David Kathoh

Sede: Goma, Repubblica Democratica del Congo

Unocane

Sviluppatore: Chinmay Mishra

Sede: Nuova Delhi, India

Agrifarm

Sviluppatore: Mirwise Khan

Sede: Balochisan, Pakistan

Stila

Sviluppatore: Yingding Wang

Sede: Monaco, Germania

Russamento e tosse

Sviluppatore: Ethan Fan

Sede: Mountain View, CA, USA

Leepi

Sviluppatore: Prince Patel

Località: Bangalore, India

Posa Mix

Sviluppatore: Peter Ma

Sede: San Francisco, CA, USA

Pathfinder

Sviluppatore: Colin Shelton

Sede: Addison, Texas, USA

Cestino

Sviluppatore: Elvin Rakhmankulov

Sede: Chicago, Illinois, Stati Uniti

Agrodoc

Sviluppatore: Navneet Krishna

Località: Kochi, India

Costruire il futuro con un'innovazione utile

Parole di Luke Dormehl

Illustrazione di Hannah Perry

"Le innovazioni del machine learning stanno già rendendo la nostra vita quotidiana più semplice e ricca."

Un occhio rosso fisso fissa l'utente. Il sistema parla con una voce fredda e non emotiva. "Mi dispiace, Dave", dice. "Temo di non poterlo fare". In questa scena iconica di 2001: Odissea nello spazio, il protagonista affronta l'assistente meno utile del mondo, HAL 9000. In nome dell'autoconservazione, il sistema di AI sostituisce gli ordini, portando alla scomparsa dell'equipaggio. Questo non è il futuro che tutti vogliono vedere. Le persone vogliono computer che aiutino l'umanità, che non li sostituiscano o ostacolano. Speriamo in un mondo utopico e non distopico in cui la tecnologia aiuti a trovare soluzioni, non più problemi. La tecnologia oggi è più potente che mai, quindi il modo in cui la creiamo e la utilizziamo deve essere altrettanto importante del suo funzionamento. Mettendo l'umanità al centro, possiamo costruire una tecnologia che cambi in meglio il nostro futuro.

Non che dobbiamo aspettare fino a quel momento, ovviamente. Numerose tecnologie per la disabilità basate sulle innovazioni del machine learning stanno già semplificando e arricchendo la nostra vita quotidiana. All'orizzonte stanno iniziando ad apparire auto a guida automatica, potenzialmente in grado di ridurre congestione, inquinamento e incidenti stradali. Mentre altre tecnologie, come gli strumenti di traduzione assistita dal ML, i software di diagnostica medica e i dispositivi sensibili al contesto, fanno parte della routine quotidiana di molte persone. Funzionalità tra cui Scrittura intelligente in Gmail, che fornisce suggerimenti durante la digitazione dei messaggi da parte degli utenti; Trascrizione istantanea in Android, che può aiutare le persone sorde o con disabilità uditiva, a ricevere sottotitoli istantanei con conversione della voce in testo in più di 70 lingue e dialetti; o l'Assistente Google, sempre di supporto, che aiuta milioni di persone a tenere sotto controllo i propri impegni quotidiani, per mettere in mostra la visione di Google per la creazione di una tecnologia migliore.

Questa idea di innovazione utile è più importante dei dispositivi mobili. Dal lancio di Android nel 2008, è diventata la piattaforma mobile più popolare al mondo. I progressi nel riconoscimento delle immagini con il machine learning consentono agli utenti di puntare la fotocamera dello smartphone verso il testo e di tradurlo in tempo reale in 88 lingue diverse tramite Google Traduttore. E ora che i telefoni cellulari stanno diventando il dispositivo preferito in tutto il mondo, soprattutto nei mercati in rapida crescita dei paesi in via di sviluppo, è fondamentale che i nuovi strumenti siano creati tenendo conto delle applicazioni incentrate sulla persona. Un'innovazione utile ha il potenziale di cambiare il modo in cui accediamo, utilizziamo e interpretiamo le informazioni, rendendole disponibili quando ne abbiamo bisogno e dove ne abbiamo maggiormente bisogno.

Ciò significa prevedere le inondazioni e inviare avvisi direttamente alle persone interessate. O persino scattare una breve foto di un articolo, ad esempio una tazza di caffè, e cercare le indicazioni stradali per raggiungere un centro di riciclo nelle vicinanze. Lo sviluppo di nuove tecnologie non è un percorso semplice. Si basa sui progressi dell'hardware, sulle nuove scoperte nel software e sugli sviluppatori che creano queste nuove esperienze. Concentrandosi sull'"Innovazione utile", Android Developer Challenge mette in azione per gli utenti esempi reali di machine learning e ispira la prossima ondata di sviluppatori a sbloccare ciò che è possibile ottenere con questa nuova tecnologia.

Progettare un'esperienza centrata sull'essere umano

Parole di Christopher Katsaros

Intervista di Joanna Goodman

Illustrazione di Ori Toor

Se ti sei appena laureato, un topo è quella fastidiosa creatura che a volte si insinua nel dormitorio di notte. Hai usato il mouse del computer solo poche volte ed è stato collegato a un sistema obsoleto nel seminterrato della biblioteca della scuola. Tuttavia, se puoi crederci, il mouse del computer è stato un passo radicale verso la personalizzazione del computer, che ne semplificava l'interazione.

Quando il fondatore di Digital Equipment Corporation, un importante produttore americano di computer dagli anni '60 agli anni '90, dichiarò "non c'è motivo per cui qualcuno voglia un computer a casa", Steve Jobs ha aperto la mente all'interfaccia utente grafica, con il mouse al centro, inaugurando il personal computing e una nuova era del design. Da allora, la progettazione dell'informatica ha subito altre due importanti rivoluzioni, ciascuna delle quali è stata un passo in avanti per rendere il nostro rapporto con i dispositivi più stretto, personale e umano.

Android e iOS hanno portato al primo importante cambiamento, con l'ondata dei dispositivi mobili. All'inizio, i dispositivi mobili significavano meno: schermi più piccoli, meno energia, meno funzionalità. Ma gli sviluppatori hanno capito subito che era di più. Scorrere, toccare, toccare, colpire (il gergo dei dispositivi mobili) ne ha reso di più pensando al di là dello schermo; la nostra tela non è più i bordi di un monitor, ora ci sono strati su livelli di informazioni, pronti a servirti. E con il contesto della posizione e dell'identità, da allora, la progettazione del computing ha subito altre due rivoluzioni importanti, ciascuna delle quali è stata un passo in più per rendere il nostro rapporto con i dispositivi più stretto, più personale e più umano.

Android e iOS hanno portato al primo importante cambiamento, con l'ondata dei dispositivi mobili. All'inizio, i dispositivi mobili significavano meno: schermi più piccoli, meno energia, meno funzionalità. Ma gli sviluppatori hanno capito subito che era di più. Scorrere, toccare, toccare, colpire (il gergo dei dispositivi mobili) ne ha reso di più pensando al di là dello schermo; la nostra tela non è più i bordi di un monitor, ora ci sono strati su livelli di informazioni, pronti a servirti. E con il contesto di posizione, identità, movimento, le esperienze umane sbloccate tramite i dispositivi mobili sminuiscono quelle che i computer potrebbero offrire. Il machine learning, il prossimo importante cambiamento, ha messo perfettamente in evidenza l'evoluzione verso una progettazione incentrata sulla persona.

Se fosse audace suggerire che i computer potrebbero mai risiedere in casa tua, sarebbe sicuramente più audace poter conversare con loro. Puoi anche puntare la fotocamera su un bel fiore, usare Google Lens per identificarne il tipo e poi impostare un promemoria per ordinare un bouquet per la mamma "Google Lens è in grado di utilizzare i modelli di visione artificiale per espandere e accelerare la ricerca", afferma Jess Holbrook, Senior Staff User Researcher di Google e co-responsabile del team di ricerca di People + AI. "Non è sempre necessario avere la fotocamera per eseguire una ricerca, ma è utile se dimentichi il nome di qualcosa o devi fermarti e digitare una descrizione lunga. Usare la videocamera è molto più veloce."

Risolvere i problemi umani

Parole di Luke Dormehl

Illustrazione di Manshen Lo

Yossi Matias è Vice President of Engineering di Google, fondatore e direttore generale del R&D Center di Google in Israele,e co-Lead of AI for Social Good.

In qualità di leader di pensiero di spicco nel campo dell'AI, Matias parla del potenziale del machine learning on-device, degli ambienti intelligenti e dell'utilizzo dell'AI per il bene dell'umanità.

D. Cosa motiva il tuo lavoro e l'interesse per l'IA?

R. Mi interessa sviluppare la tecnologia e utilizzarla per risolvere problemi difficili in modi che abbiano un impatto. I progetti a cui sto lavorando includono iniziative di IA di conversazione come Google Duplex, un sistema automatizzato che utilizza voci dal suono naturale per svolgere al telefono attività come fare prenotazioni al ristorante; Read It, che consente all'Assistente Google di leggere articoli web ad alta voce dal telefono e tecnologie on-device come Filtro chiamate e Sottotitoli in tempo reale. Mi interessa molto anche l'uso generale dell'IA per il bene sociale. Ne sono un esempio una migliore previsione delle inondazioni utilizzando il machine learning, il cloud computing, le simulazioni idrauliche e altre tecnologie.

D. Come è nata l'iniziativa AI for Social Good?

R. Un bellissimo attributo che vedo nella cultura di Google è che a molte persone interessa trovare modi per risolvere problemi importanti utilizzando la tecnologia. L'IA per il bene sociale può essere applicata in molti ambiti: salute, biodiversità, aiuto nell'accessibilità, nella risposta alle crisi, sostenibilità e così via. Alcuni di noi di Google si sono riuniti e hanno identificato dei problemi che, se saremo in grado di aiutarli a risolverli, avrebbero portato grandi vantaggi alla vita delle persone e alla società. Abbiamo quindi creato AI for Social Good per supportare chiunque, all'interno o all'esterno di Google, impegnati a realizzare iniziative correlate al bene sociale. Le tecnologie di machine learning odierne, disponibili tramite il cloud, consentono a molte persone in tutto il mondo di ottenere gli strumenti per identificare e potenzialmente risolvere problemi sociali reali. Una storia senza pari.

D. Quali ruoli possono svolgere le tecnologie on-device?

I dispositivi mobili di oggi sono sempre più potenti. Questo ci offre l'opportunità di sfruttare tecniche di machine learning eseguibili sul dispositivo. Ciò è importante per diversi motivi, ad esempio per la possibilità di accedere istantaneamente a determinate applicazioni senza dipendere dalla connettività. È importante anche in situazioni in cui potresti avere a che fare con dati personali, in cui non vuoi che nulla lasci il tuo dispositivo. Filtro chiamate, Sottotitoli in tempo reale e Relay in tempo reale sono esempi di come l'utilizzo dell'IA conversazionale sul dispositivo può aiutare le persone ad avere un maggiore controllo sulle chiamate in arrivo, consentire a chi ha difficoltà uditive di vedere i sottotitoli in tempo reale di ciò che viene detto e persino avere conversazioni telefoniche.

D. Perché l'intelligenza ambientale è stata così rivoluzionaria?

R. La potenza di una tecnologia utile emerge quando è così incorporata nel nostro ambiente da funzionare senza che noi dobbiamo prestare attenzione. All'inizio molte tecnologie ci sorprendono, ma presto le diamo per scontate. L'IA conversazionale elimina le barriere di modalità e linguaggi e consente una migliore interazione. Facendo in modo che le macchine ci capiscano meglio e ci parlino in modo naturale, praticamente diventando ambiente, gli utenti possono eliminare il carico cognitivo dovuto al dover chiedere esplicitamente qualcosa da fare e interagire in modo più naturale.

D. Perché è così importante che gli strumenti di machine learning siano resi accessibili?

R. L'Android Developer Challenge mostra l'importanza di aprire il cloud e la tecnologia on-device. Ci piace assistere alle innovazioni che arrivano da tutto il mondo e da tutti. Vogliamo essere in grado di incoraggiare, sostenere, ispirare e consigliare ovunque possiamo. Sono davvero entusiasta di ciò che ho ottenuto da coloro che hanno partecipato a questo programma. Se saremo in grado di aiutarli a scalare la loro passione a livello globale e a sfruttare tecnologie all'avanguardia, osserveremo risultati sorprendenti e innovativi, che possono essere assolutamente utili per le persone.

TensorFlow Lite: il livello di base

Parole di Luke Dormehl

Illustrazione di Sarah Maxwell

Come potete sfruttare le funzionalità e gli strumenti di machine learning rivoluzionari su un dispositivo mobile? La risposta è TensorFlow Lite. Questo potente framework di machine learning può aiutare a eseguire modelli di machine learning su dispositivi Android e iOS che normalmente non sarebbero mai in grado di supportarli. Oggi TensorFlow Lite è attivo su miliardi di dispositivi in tutto il mondo. Inoltre, il suo set di strumenti può essere utilizzato per tutti i tipi di potenti applicazioni correlate alla rete neurale, dal rilevamento delle immagini al riconoscimento vocale, per introdurre la tecnologia all'avanguardia nei dispositivi che portiamo con noi, ovunque ci troviamo.

TensorFlow Lite consente di eseguire gran parte dell'elaborazione del machine learning sui dispositivi stessi, utilizzando modelli con minore intensità di calcolo, che non devono dipendere da un server o un data center. Questi modelli sono più veloci, offrono potenziali miglioramenti della privacy, richiedono meno energia (la connettività può essere un problema di batteria) e, soprattutto, in alcuni casi, non richiedono una connessione a internet. Su Android, TensorFlow Lite accede ad acceleratori specializzati per dispositivi mobili tramite l'API Neural Network, fornendo prestazioni ancora migliori e riducendo al contempo il consumo di energia.

"TensorFlow Lite consente casi d'uso che prima non erano possibili perché le latenze di round trip al server rendevano tali applicazioni un comando non iniziale", afferma Sarah Sirajuddin, Engineering Director di TensorFlow Lite. "Ad esempio, il riconoscimento vocale sul dispositivo, le funzionalità interattive video in tempo reale e i miglioramenti in tempo reale al momento dell'acquisizione delle foto." "L'innovazione in questo settore è stata enorme e ce ne saranno altre in arrivo", prosegue. "L'altro aspetto entusiasmante è che semplifica il machine learning, contribuendo a supportare la creatività e il talento."

Parole di Luke Dormehl

Illustrazione di Sarah Maxwell

ML Kit: rendere il machine learning più accessibile

Parole di Joanna Goodman

Illustrazione di Tor Brandt

ML Kit offre le tecnologie di machine learning on-device di Google agli sviluppatori di app mobile, in modo che possano creare esperienze personalizzate e interattive nelle loro app. Sono inclusi strumenti come traduzione linguistica, riconoscimento del testo, rilevamento di oggetti e altro ancora. ML Kit consente di identificare, analizzare e, in una certa misura, comprendere dati visivi e di testo in tempo reale e nel rispetto della privacy dell'utente, poiché i dati rimangono sul dispositivo. "Rende il machine learning molto più accessibile", afferma Brahim Elbouchikhi, Director of Product Management.

"Rendiamo disponibili i migliori modelli ML di Google come un semplice set di strumenti, quindi gli sviluppatori non hanno più bisogno di essere esperti di ML per creare app basate su ML. Tutta la complessità è nascosta, quindi gli sviluppatori possono concentrarsi sul loro prodotto principale". Ad esempio, strumenti come Language ID ti aiutano a identificare la lingua di una stringa di testo, mentre il rilevamento e il monitoraggio degli oggetti possono aiutare a localizzare e monitorare in tempo reale uno o più oggetti in un'immagine o in un feed videocamera dal vivo.

È ciò che aiuta le app vincenti nell'Android Developer Challenge, come Cestino, a distinguere tra materiali riciclabili e non riciclabili, oppure UnoDogs aiuta a distinguere tra cani sani da cani non sani. E per quanto riguarda il futuro? L'obiettivo è far sparire la tecnologia in secondo piano e consentire ai dispositivi di comprendere meglio le nostre esigenze, afferma Elbouchikhi. "ML Kit ci aiuta a mantenere questa promessa, consentendo agli sviluppatori di creare esperienze intuitive e adattive, in modo da promuovere la privacy e la fiducia degli utenti."

Parole di Joanna Goodman

Illustrazione di Tor Brandt

Eskke

Sviluppatori: David Mumbere Kathoh, Nicole Mbambu Musimbi

Sede: Goma, Repubblica Democratica del Congo

Oggi, oltre 400 milioni di persone utilizzano quotidianamente un servizio chiamato "Money mobile", che consente di inviare denaro, pagare le bollette o prelevare denaro dai kiosk per denaro mobile tramite USSD, ovvero i codici rapidi inviati sul telefono. Sebbene il denaro mobile sia utilizzato dalle persone in tutto il mondo, è particolarmente utile per chi risiede in un paese come la Repubblica Democratica del Congo (RDC), dove il 46% della popolazione vive in aree rurali senza banche tradizionali o una connessione stabile a internet. Sfortunatamente, la procedura è dispendiosa in termini di tempo ed è difficile da usare, in particolare per le persone che hanno difficoltà a leggere e lavorare con i numeri. C'è una mossa sbagliata e devono ricominciare da capo.

Oppure, se viene utilizzato un codice sbagliato, il denaro potrebbe essere inviato alla persona sbagliata. Esske semplifica l'esperienza, rendendola più intuitiva e accessibile. All'interno dell'app, gli utenti possono anche leggere e monitorare le transazioni in tempo reale e anche trasferire denaro, pagare fatture, acquistare abbonamenti e passare il tempo di trasmissione necessario per inviare SMS, utilizzare i dati e fare chiamate. Mentre la maggior parte dei servizi di mobile banking richiede agli utenti di inserire manualmente il codice USSD del proprio cellulare, la funzione Quick Redraw di Eskke elabora queste informazioni automaticamente.

Strumenti come il riconoscimento del testo offline e la scansione di codici a barre di ML Kit consentono agli utenti di scansionare semplicemente il codice QR presso un kiosk mobile per prelevare denaro e prelevare rapidamente denaro. L'app è disponibile per gli utenti nella Repubblica Democratica del Congo e verrà ampliata per supportare gli operatori di moneta mobile in altri paesi africani.

Parole di Arielle Bier

Illustrazione di Frances Haszard

arrow_upwardCestino

Sviluppatori: Elvin Rakhmankulov, Arthur Dickerson, Gabor Daniel Vass, Yury Ulasenka

Sede: Chicago, USA

Con il cambiamento climatico che si sta diffondendo in tutto il mondo, le persone stanno cercando di ridurre la propria impronta di carbonio e di inviare meno rifiuti in discarica.

Sebbene la maggior parte delle città fornisca servizi di riciclo, molti luoghi hanno regole, restrizioni e normative diverse. A causa di un'etichettatura scadente e di norme incoerenti, gli oggetti non riciclabili occupano oltre il 25% dei cassonetti per il riciclo.

Cestino facilita il riciclo per i consumatori. Basta puntare la fotocamera sul dispositivo verso un articolo e, tramite il rilevamento degli oggetti, l'app identifica e classifica bicchieri, sacchetti, bottiglie di plastica e carta e così via. Dopo aver analizzato queste informazioni tramite un modello TensorFlow Lite personalizzato, indica se l'oggetto è riciclabile e come viene riciclato, a seconda delle norme locali, e fornisce dettagli sui cestini di riciclo nelle vicinanze.

Attualmente attiva in Illinois, Pennsylvania e California, Cestino consente di trovare 1000 centri di riciclo utilizzando la funzionalità "Vicino a me" e prevede di estenderla ad altri stati e paesi in futuro, contribuendo a supportare abitudini responsabili che fanno la differenza.

Parole di Arielle Bier

Illustrazione di Aless Mc

arrow_upwardUnocane

Sviluppatore: Chinmay Mishra

Sede: Nuova Delhi, India

"Vogliamo utilizzare il machine learning per consentire a ogni proprietario di cani di valutare con precisione la salute generale del proprio cane e di lavorarci sopra."

I cani dipendono dai padroni per l'attività fisica, il cibo e la cura quotidiani. Tuttavia, nonostante le migliori intenzioni, molti amati cani finiscono in sovrappeso, riducendo la vita media degli animali fino al 25%. UnoDogs aiuta i proprietari a supportare meglio il benessere del loro animale domestico, fornendo informazioni personalizzate e programmi di fitness. Monitorando e misurando la salute di un cane e fornendo consigli accurati, UnoDogs affronta i problemi di salute prima che inizino.

Utilizzando la funzionalità AutoML Vision di Google Cloud Platform per addestrare un modello di rilevamento degli oggetti al fine di analizzare le immagini in tempo reale, UnoDogs è in grado di calcolare il punteggio relativo alle condizioni del corpo del cane e di fornire consigli per peso e dimensioni ideali. Nelle versioni future,saranno disponibili altre funzionalità basate su ML, come suggerimenti di alimenti, test di agilità e piani di fitness.

I dettagli sul monitoraggio del peso e dell'allenamento vengono poi combinati con l'analisi in tempo reale, offrendo pasti e programmi di allenamento facili da seguire, progettati per mantenere il proprietario sulla strada giusta e trovare l'ispirazione in modo che il suo cane possa condurre una vita migliore.

Parole di Arielle Bier

Illustrazione di Choi Haeryung

arrow_upwardAgrifarm

Sviluppatori: Mirwise Khan, Samina Ismail, Ehtisham Ahmed, Hassaan Khalid

Sede: Belucisan, Pakistan

"Stiamo aiutando a mettere in contatto gli agricoltori e a utilizzare l'AI per la loro produttività."

Le malattie delle colture rappresentano una minaccia costante per gli agricoltori di tutto il mondo. E l'impatto dell'insicurezza alimentare sulla salute, sulla società e sull'economia può essere devastante. AgriFarm aiuta gli agricoltori a rilevare le malattie delle piante, prevenendo gravi danni. Per rendere possibile tutto ciò, il classificatore di rete neurale profondo, utilizzato per identificare il tipo di malattia, è ospitato su Google Cloud AI Platform.

Altre funzionalità includono bollette meteo, consigli sui video e previsioni sui prezzi. Progettata per essere utilizzata in aree rurali remote, con accesso a Internet limitato, AgriFarm si occupa di frutta e verdura come pomodori, mais e patate e sta espandendo il set di dati in modo che funzioni a livello globale.

Parole di Arielle Bier

Illustrazione di Buba Viedma

arrow_upwardAgroDoc

Sviluppatore: Navneet Krishna

Sede: Kochi, India

"AgroDoc potrebbe davvero aiutare queste persone con meno esperienza nell'agricoltura."

Basato su un modello di crowdsourcing, AgroDoc aiuta a raccogliere dati da agricoltori con aree geografiche e climi simili per diagnosticare le malattie delle piante e preparare piani di trattamento. Con l'app, una foglia infetta viene scansionata da una fotocamera sul dispositivo e la libreria TensorFlow Lite aiuta a rilevare il tipo di malattia.

I dati vengono analizzati in combinazione con sintomi chiave e vengono indicati semplici passaggi per migliorare la salute della pianta.

Parole di Arielle Bier

Illustrazione di Buba Viedma

arrow_upwardStila

Sviluppatore: Yingding Wang

Sede: Monaco, Germania

"Nella società moderna, le cose stanno cambiando così rapidamente e la pressione sul lavoro è così elevata che il nostro corpo reagisce a queste sfide, come essere cacciato da una tigre."

Lo stress esiste in molte forme, sia positive che negative. Fortunatamente, il nostro corpo è fatto per autoregolarsi e adattarsi alle mutevoli circostanze. Tuttavia, quando eventi o condizioni estremi causano livelli elevati di stress, possono verificarsi effetti negativi, che causano ansia, depressione e danni a lungo termine alla salute. Stila (monitoraggio dello stress nelle attività di apprendimento), monitora e traccia i livelli di stress del corpo, in modo che gli utenti possano comprendere e gestire meglio lo stress nella loro vita. Per rendere possibile tutto ciò, l'app per smartphone interagisce con un dispositivo indossabile, come il braccialetto Fitbit o un dispositivo in esecuzione su Wear OS by Google, per la registrazione del biofeedback.

Un modello personalizzato Firebase rileva e classifica lo stress, mentre l'interprete TensorFlow Lite consente l'elaborazione delle informazioni offline. L'app monitora i livelli di stress del corpo ed è combinata con brevi report sugli eventi della vita e sull'ambiente dell'utente. In seguito, viene calcolato un punteggio per il livello di stress, contribuendo a stimare lo stress durante determinate attività. Poiché ogni persona reagisce a fattori di stress e stimoli in modi diversi, Stila impara da questi report e adatta il suo funzionamento. Quindi fornisce un feedback in base ai ritmi e alle esigenze di ogni utente.

I singoli trait possono essere utilizzati per contribuire ulteriormente a personalizzare l'esperienza utente attraverso il Transfer Learning. Rilevando e monitorando i livelli di stress nel tempo, gli utenti hanno la possibilità di gestire meglio lo stress nella loro vita.

Parole di Arielle Bier

Illustrazione di Linn Fritz

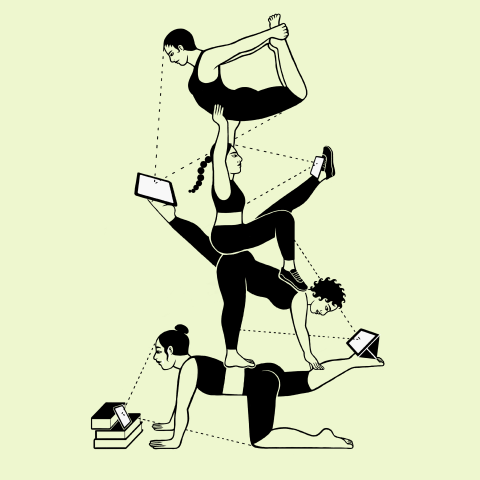

arrow_upwardPosa Mix

Sviluppatori: Peter Ma, Sarah Han

Sede: San Francisco, USA

"Siamo tutti praticanti di yoga e siamo tutti sviluppatori di software. Volevamo esplorare in che modo le tecnologie possono aiutare a migliorare le esperienze di yoga e fitness."

MixPose è una piattaforma di live streaming che offre agli insegnanti di yoga e ai professionisti del fitness l'opportunità di insegnare, monitorare l'allineamento e fornire feedback in tempo reale. I video statici di fitness condividono informazioni solo in una direzione. Tuttavia, grazie a questa app, gli insegnanti possono personalizzare le lezioni e interagire direttamente con le esigenze dei loro studenti. Il monitoraggio della posa rileva i movimenti di ciascun utente e le posizioni sono classificate utilizzando ML Kit e PoseNet.

In seguito, sensori in tempo reale e sistemi di feedback li informano del loro allineamento. È possibile aggiungere output alle funzionalità video, come Chromecast, per connettersi facilmente a schermi più grandi per una visualizzazione più immersiva. Progettata pensando ai 37 milioni di americani che praticano yoga, MixPose si avvale di oltre 100 insegnanti di yoga per il suo lancio. Innovando tramite l'AI a livello perimetrale, il 5G e la smart TV, questa piattaforma offre corsi interattivi direttamente agli utenti nel comfort di casa loro.

Parole di Arielle Bier

Illustrazione di Rachel Levit Ruiz

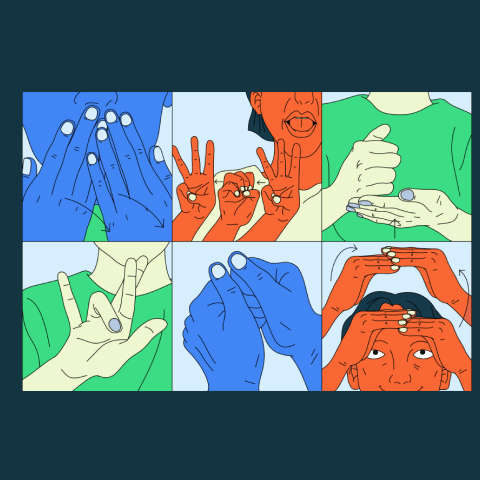

arrow_upwardLeepi

Sviluppatori: il principe Patel, Aman Arora, Aditya Narayan

Sede: Bangalore, India

"Circa 7 milioni di persone in India hanno capacità diverse di sentire e parlare."

Oltre sette milioni di persone in India hanno capacità diverse di sentire e parlare, ma poche hanno accesso all'istruzione con la lingua dei segni. Poiché la gamma di lingue e dialetti è così diversificata, creare una forma di comunicazione standard è quasi impossibile.

Con Leepi, gli studenti possono imparare a usare gesti e simboli delle mani per la lingua dei segni americana. L'app utilizza il riconoscimento di lettere, simboli, facciali e di intenti, con esercizi interattivi e feedback in tempo reale. La libreria TensorFlow Lite e il framework MediaPipe sono stati utilizzati per rendere l'elaborazione sul dispositivo più accurata e semplificata. Inoltre, è progettato per l'utilizzo offline, così un numero maggiore di studenti può imparare senza barriere.

Parole di Arielle Bier

Illustrazione di Xuetong Wang

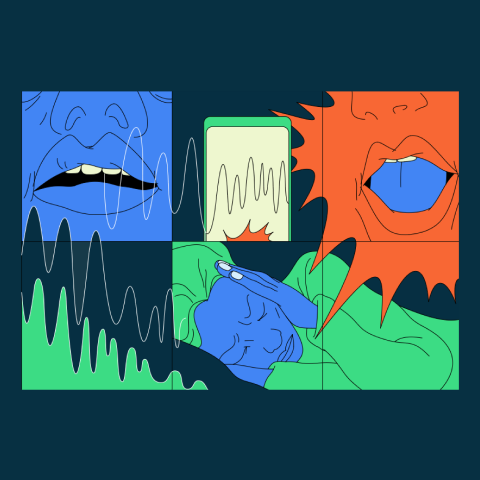

arrow_upwardRussamento e tosse

Sviluppatore: Ethan Fan

Sede: Mountain View, CA, Stati Uniti

"La nostra soluzione consiste nell'utilizzare la classificazione audio attraverso il deep learning."

Dormire bene è fondamentale per riposare e rigenerare il corpo umano. Eppure il 25% degli adulti russa regolarmente, il che potrebbe causare interruzioni del sonno e problemi di salute potenzialmente cronici.

Attraverso l'acquisizione, l'analisi e la classificazione dell'audio con TensorFlow Lite, l'app Russamento e tosse identifica russamento e tosse per aiutare gli utenti a richiedere assistenza a un medico.

Parole di Arielle Bier

Illustrazione di Xuetong Wang

arrow_upwardRicerca percorso

Sviluppatori: Colin Shelton, Jing Chang, Sam Grogan, Eric Emery

Sede: Addison, Texas, USA

"Volevamo sfruttare il machine learning per raggiungere un bene pubblico."

Quando si viaggia in ambienti pubblici, come un centro commerciale o una strada affollata, gli ostacoli in movimento si spostano costantemente e cambiano in modi inaspettati. Esperienze sensoriali come la vista, i suoni e il tatto possono aiutare a evitare collisioni e incidenti. Tuttavia, per le persone con disabilità visiva, navigare in ambienti pubblici significa dover affrontare una serie di incognite. Path Finder potrebbe aiutare le persone con disabilità visiva a superare situazioni così complesse identificando e calcolando le traiettorie degli oggetti che si muovono lungo il loro percorso.

Successivamente, gli avvisi personalizzati informano l'utente su come evitare questi ostacoli e suggeriscono azioni che può effettuare in sicurezza. Questa app utilizza il rilevamento degli oggetti da TensorFlow Lite per calcolare le distanze degli oggetti circostanti. È progettato per migliorare l'esperienza dell'utente, condividere informazioni e fornire assistenza, senza sovraccaricarlo in situazioni difficili. Per questo motivo, il processo di configurazione di Path Finder è pensato per favorire la conversazione ed è personalizzato per gli utenti con una visione limitata, così come per le persone che li aiutano.

Sia il feedback udibile che quello aptico fanno parte del sistema di allarme ostacoli, mentre una serie di altezze e frequenze comunica la distanza e la direzione di ciascun oggetto. I pattern audio, come il codice Morse, vengono quindi sovrapposti e combinati per condividere ulteriori informazioni. Path Finder può aiutare gli utenti con disabilità visiva a sfruttare la lungimiranza, semplificando la navigazione negli ambienti pubblici.

Parole di Arielle Bier

Illustrazione di Sonya Korshenboym

arrow_upward